Le fabricant de puces et de cartes graphiques américain Nvidia a annoncé DGX-2, un serveur surpuissant proposant 2 pétaflops de puissance de calcul pour les charges de travail liées à l’apprentissage machine et à l’IA. Ce dernier est annoncé comme 10 fois plus rapide que le précédent lancé six mois auparavant.

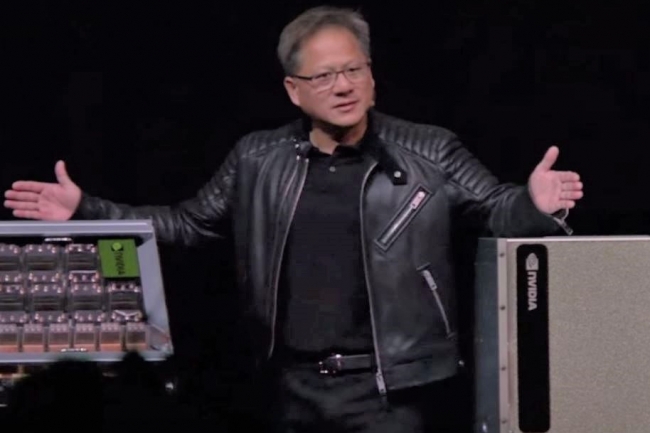

Jensen Huang, CEO de Nvidia, sur la scène de la GTC 2018 à San José pour présenter le nouveau serveur Nvidia DGX-2 taillé pour le deep learning. (crédit : Nvidia)

Lors de la conférence GTC 2018 consacrée à l’IA et au deep learning qui se tenait du 26 au 29 mars à San José (Silicon Valley), Nvidia a annoncé que son GPU Tesla V100, déjà largement adopté par les chercheurs, était désormais disponible sur l’ensemble de sa gamme de systèmes de deep learning DGX. Lors de cette 10e conférence, Nvidia en a profité pour lever le voile sur une série de nouveaux produits dotés de capacités deep learning avancées, en particulier un serveur surpuissant DGX-2 capable de fournir à lui seul deux pétaflops de puissance de calcul pour les charges de travail d’intelligence artificielle. Le fondateur et CEO de Nvidia Jensen Huang a aussi annoncé que l’entreprise avait doublé la mémoire de sa carte accélératrice Tesla V100 à 32 Go afin de renforcer ses capacités de traitement des tâches de deep learning et de calcul haute performance. Le CEO a déclaré que les capacités de calcul des GPU continueraient de croitre et qu’il faudra des ordinateurs plus grands et plus puissants pour suivre la cadence.

« Nous sommes à un tournant et le nombre de personnes qui adoptent le calcul GPU ne cesse d’augmenter », a ajouté le CEO de Nvidia. « Au cours des cinq dernières années, le nombre de développeurs GPU a été multiplié par 10 pour atteindre quasiment le million aujourd’hui ». Toujours selon Jensen Huang, « compte tenu de ce qui s’est passé au cours des cinq dernières années, il ne peut y avoir de doute sur le fait que le calcul accéléré par GPU est la bonne réponse ». La puce graphique Tesla V100, largement adoptée par les chercheurs partout dans le monde, est désormais disponible sur l’ensemble de la gamme de systèmes deep learning DGX de Nvidia.

Relever les défis les plus complexes de l’IA

Le serveur Nvidia DGX-2 est capable à lui seul de délivrer une puissance de calcul de deux pétaflops et doit permettre de relever les défis les plus complexes de l’intelligence artificielle. Sa puissance de traitement est équivalente à celle de 300 serveurs de datacenters 15 racks. Le serveur offre également 30 téraoctets d’espace de stockage et il est 10 fois plus rapide que la précédente version DGX-1 livrée il y a à peine six mois. Le DGX-2 sera généralement disponible au cours du troisième trimestre 2018 au prix de 399 000 dollars HT, mais certains chercheurs utilisent déjà le produit. « La plate-forme deep learning de Nvidia, devenue en peu de temps une référence mondiale, a déjà intégré la plupart de ces innovations », a ajouté M. Huang. « Nous améliorons les performances de notre plate-forme à un rythme qui dépasse largement la loi de Moore. Ces innovations vont révolutionner les secteurs de la santé, du transport, de la recherche scientifique et beaucoup d’autres secteurs encore ».

Le fournisseur californien a aussi annoncé la sortie de NVSwitch, un nouveau fabric d’interconnexion qui permet de faire communiquer entre eux 16 GPU Tesla V100 dans un même nœud serveur pour délivrer un débit de 2,4 téraoctets par seconde. Selon l’entreprise, cette solution résout le problème du goulet d’étranglement de la bande passante PCIe pour les systèmes à plusieurs cœurs GPU et crée une interconnexion plus rapide et plus évolutive. Selon Jensen Huang, cela permettra aux développeurs de concevoir des systèmes comportant un plus grand nombre de GPU hyperconnectés.