Pour les besoins de son moteur de recherche Bing, Microsoft a amélioré sur CPU et GPU l’inférence de l’algorithme de représentation du langage naturel Bert, de Google. Il vient de mettre en open source ces versions optimisées à travers son moteur de scoring ONNX Runtime.

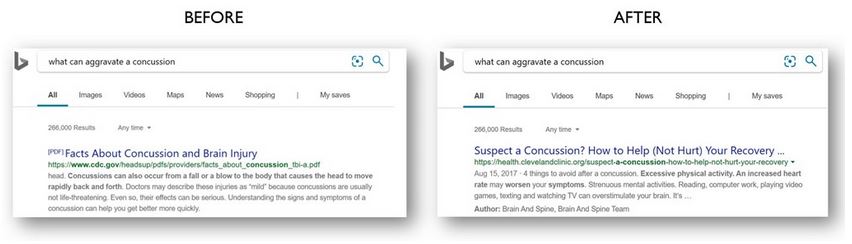

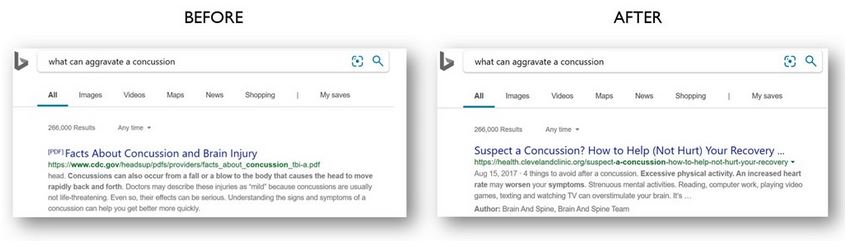

Sur Bing, la compréhension des requêtes en langage naturel a été transformée par l’utilisation de l’algorithme Bert de Google. (Microsoft)

Depuis deux ans, Microsoft exploite des modèles de deep learning pour augmenter la compréhension des requêtes utilisateurs dans les algorithmes de recherche de son moteur Bing. Celle-ci a été nettement améliorée par les modèles de réseau neuronal appelés transformers, très efficaces pour les tâches de traitement du langage naturel courant. Ces modèles transformers ont été popularisés par Google à travers l’algorithme Bert – bidirectional encoder representations from Transformers – conçu pour pré-entraîner des représentations bidirectionnelles profondes de textes en tenant compte du contexte et des relations entre les mots. En novembre, Microsoft a expliqué de quelle façon il avait pu transformer l’expérience offerte par Bing en améliorant l’inférence Bert sur ses VM Azure NV6 exploitant des GPU (NVidia Tesla P100), dans les limites de latence du moteur de recherche. « Avec ces optimisations GPU, nous avons pu utiliser plus de 2000 VM Azure GPU sur quatre régions pour servir plus d’un million d’inférences Bert par seconde au niveau mondial », décrit-il dans son billet.

Il y a deux jours, l’éditeur a annoncé dans un billet avoir mis en open source des versions améliorées de ces optimisations dans ONNX Runtime, son moteur de scoring pour les modèles ONNX, en les étendant pour qu’elles fonctionnent à la fois sur GPU et CPU. ONNX, Open neural network exchange, est un format interopérable de modèles de machine learning créé par Microsoft et Facebook en 2017 pour permettre le partage de modèles d’apprentissage machine entre différents frameworks. Accessible sur GitHub, ONNX Runtime va permettre aux développeurs en intelligence artificielle de pouvoir mettre en production, avec des temps de latence réduits, d’importants modèles de transformers sur CPU et GPU en utilisant les mêmes technologies que Microsoft avec Bing.

En novembre 2019, Microsoft avait expliqué comment il alimentait sa technologie de recherche sur Bing par des modèles permettant de comprendre l’intention de l’utilisateur. (Crédit : Microsoft) Agrandir l’image