Désormais open source, xbench utilise un mécanisme d’évaluation qui examine la capacité d’un modèle d’IA à exécuter des tâches dans le monde réel et complique l’entrainement des concepteurs de modèles.

Les benchmarks de performance IA sont nombreux sur le marché (MLperf, perfbench, benchmperf…). Cette fois c’est au tour de la société chinoise de capital-risque HongShan Capital Group (HSG) de rentrer dans l’arène avec xbench, disponible en open source. « Nous pensons que l’esprit de l’open source peut faire évoluer xbench et peut créer une plus grande valeur pour la communauté de l’IA », affirme HSG. Le 17 juin, l’entreprise a annoncé qu’elle avait officiellement livré ses deux premiers benchmarks xbench, à savoir xbench-Science QA et xbench-DeepSearch promettant qu’à l’avenir, elle mettrait « continuellement et dynamiquement à jour ces benchmarks au rythme du développement des grands modèles de langage et des agents d’IA… ». Depuis deux autres ont été lancés : xbench-Profession-recruiting et xbench-Profession-marketing.

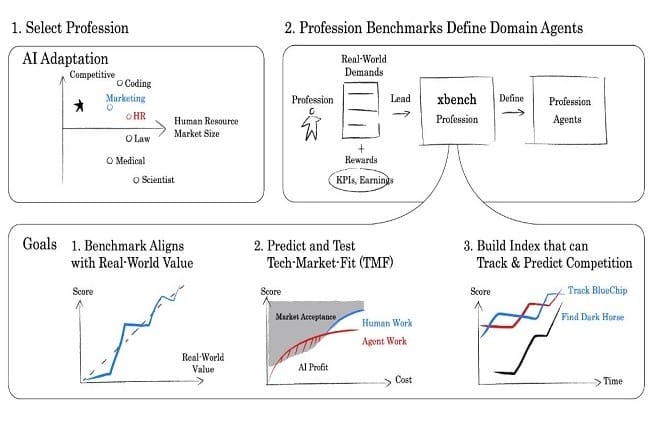

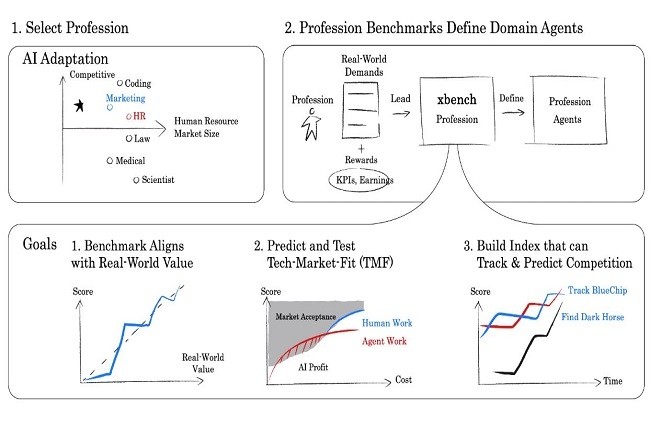

Le développement de Xbench a commencé en 2022 dans la roue du succès de ChatGPT. Initialement conçu comme un outil d’évaluation interne pour guider les décisions d’investissement de HSG, le projet s’est depuis étendu sous la direction de son partenaire Gong Yuan. Des chercheurs externes et des experts du domaine ont contribué à affiner le benchmark au fur et à mesure qu’il évoluait vers une initiative publique. Xbench utilise une double approche de l’évaluation. Une partie fonctionne comme les tests académiques traditionnels, mesurant les connaissances générales et le raisonnement dans toutes les disciplines. L’autre partie simule des entretiens d’embauche techniques, évaluant la capacité des modèles à traiter des tâches réelles et économiquement pertinentes. L’un des tests demande à une IA d’identifier cinq ingénieurs qualifiés et d’expliquer chaque choix. Un autre test consiste à mettre en relation des annonceurs avec des influenceurs vidéo à partir d’une base de données de plus de 800 candidats. D’autres catégories telles que la finance, le droit, la comptabilité et le design sont en cours de développement, bien que leurs séries de questions n’aient pas encore été publiées. Pour le recrutement, o3 d’OpenAI, Perplexity Search et Claude 3.7 Sonnet arrivent en tête. Dans le domaine du marketing, Claude, Grok et Gemini réalisent également d’excellentes performances.

Un objectif de pertinence dans le monde réel

Selon Mohit Agrawal, directeur de recherche sur l’IA et l’IoT chez CounterPoint Research, « les modèles d’IA ont dépassé les benchmarks traditionnels, en particulier dans les domaines subjectifs tels que le raisonnement. xbench cherche à combler ce fossé par sa pertinence et son adaptabilité au monde réel. Il n’est pas parfait, mais il propose une nouvelle manière de suivre l’impact pratique de l’IA ». Il ajoute que « les modèles eux-mêmes ayant progressé de manière significative au cours des deux ou trois dernières années, les critères d’évaluation doivent évoluer en tenant compte de leurs capacités changeantes ». Pour M. Agrawal, « xbench vise à combler les lacunes des méthodes d’évaluation traditionnelles, ce qui constitue un premier pas bienvenu vers des benchmarks plus pertinents et plus modernes. xbench tente d’apporter une pertinence dans le monde réel tout en restant dynamique et adaptable. »

Cependant, selon M. Agrawal, s’il est relativement facile d’évaluer des modèles pour des tâches de mathématiques ou de codage, « il est beaucoup plus difficile d’évaluer des modèles dans des domaines subjectifs tels que le raisonnement ». Les modèles de raisonnement peuvent être appliqués dans une grande variété de contextes, et ils peuvent se spécialiser dans des domaines particuliers. « Dans de tels cas, la subjectivité nécessaire est difficile à saisir avec n’importe quel benchmark », a-t-il estimé. « De plus, cette approche nécessite des mises à jour fréquentes et l’intervention d’experts, ce qui peut être difficile à maintenir et à mettre à l’échelle ». Il ajoute encore que « des biais peuvent se glisser dans l’évaluation, en fonction du domaine et de l’origine géographique des experts ». Dans l’ensemble, xbench constitue une première étape importante et, avec le temps, il pourrait devenir une référence pour évaluer l’impact pratique et la maturité commerciale des agents d’intelligence artificielle ». Hyoun Park, CEO et chief analyst chez Amalgam Insights, émet cependant quelques réserves à ce sujet. « On ne peut que saluer l’effort visant à actualiser et à améliorer les benchmarks de l’IA, car les benchmarks dynamiques sont nécessaires sur un marché où les modèles changent tous les mois, voire toutes les semaines », a-t-il reconnu. « Mais là où j’exprime une certaine réserve, c’est que les critères d’évaluation de l’IA doivent à la fois être mis à jour au fil du temps et changer réellement au fil du temps. »

Des derniers cas d’usage à évaluer

« Les efforts comme ceux entrepris par Databricks avec ses Agent Bricks montrent qu’il est important de construire des benchmarks indépendants pour les nouveaux cas d’usages et les cas d’usages émergents. Salesforce Research a récemment publié un document montrant que les LLM ne réussissent pas à mener à bien certaines tâches pratiques, même lorsqu’ils sont capables de mener à bien les capacités techniques associées à la tâche », a aussi fait remarquer M. Park. « Souvent, la valeur d’un LLM ne réside pas dans la capacité à résoudre un problème spécifique, mais à identifier quand une approche nouvelle ou difficile peut s’avérer nécessaire. Et cela va constituer un défi, même pour ce benchmark évolutif, car l’objectif actuel est de trouver des questions plus complexes qui peuvent être directement résolues par les LLM plutôt que de déterminer si ces tâches complexes sont nécessaires, sur la base d’un questionnement plus ouvert et plus généralisé », a-t-il ajouté

Par ailleurs, selon M. Park, « pour 99 % des utilisateurs, il est probablement plus important de savoir qu’ils doivent conceptuellement être conscients de la complexité de Vapnik-Chervonenkis [une mesure de la complexité d’un modèle] pour comprendre la robustesse d’un défi qu’un modèle d’IA tente de résoudre. Du point de vue de la valeur, il est plus utile de fournir un contexte pour savoir si la dimension VC d’un défi peut être considérée comme faible ou élevée, parce qu’il y a des ramifications pratiques sur l’utilisation d’un petit ou d’un grand modèle d’IA pour résoudre le problème, qui peuvent se traduire par des différences de coût de plusieurs ordres de grandeur. » M. Park rappelle que « le benchmarking des modèles a été un véritable défi, car l’exercice est à la fois extrêmement important dans les guerres de l’IA, qui se chiffrent en milliards de dollars, et mal défini ». Selon lui, « un tas de raisons peuvent inciter les entreprises d’IA à tricher et à sur-adapter leurs modèles à des tests et à des benchmarks spécifiques. »