Actuellement en version bêta privée, cet agent de sécurité alimenté par GPT-5 analyse, raisonne et corrige les logiciels comme un véritable chercheur, intégrant une défense basée sur l’IA dans le processus de développement.

Les apports de l’IA dans le domaine de la sécurité logicielle progresse. OpenAI vient de présenter en version de test privé Aardvark (en référence à l’animal nommé oryctérope), un agent capable d’analyser, de comprendre et de corriger le code avec les mêmes capacités de raisonnement qu’un analyste spécialisé dans les vulnérabilités. Contrairement aux scanners conventionnels qui signalent mécaniquement les codes suspects, Aardvark tente d’analyser comment et pourquoi le code se comporte d’une manière particulière.

La solution « est différente car il fait ce que ferait un chercheur en sécurité », a déclaré Pareekh Jain, DG d’EIIRTrend (plateforme d’ingénierie). « Il utilise un raisonnement alimenté par LLM pour comprendre la sémantique et le comportement du code, en le lisant et en l’analysant comme le ferait un expert humain », a-t-il poursuivi. « En s’intégrant directement dans le pipeline de développement, Aardvark répond à une préoccupation de sécurité post-développement en apportant une protection continue qui évolue avec le logiciel lui-même », a ajouté le dirigeant.

Une validation de la sémantique du code jusqu’aux correctifs

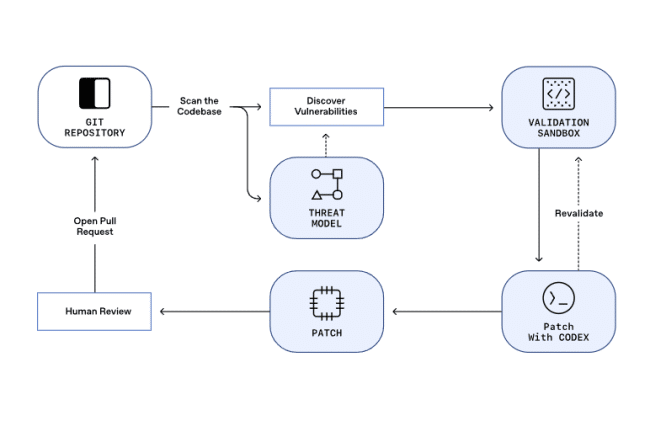

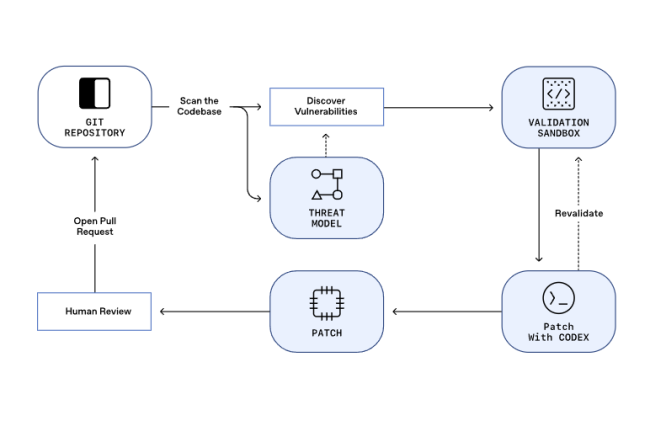

Selon OpenAI, ce qui rend Aardvark unique, c’est sa capacité à combiner raisonnement, automatisation et vérification. Plutôt que de mettre simplement en évidence les vulnérabilités potentielles, l’agent promet une analyse en plusieurs étapes, en commençant par cartographier l’ensemble d’un référentiel et en construisant un modèle de menace contextuel autour de celui-ci. À partir de là, il surveille en permanence les récents commits, vérifiant si chaque modification introduit un risque ou enfreint les modèles de sécurité existants. De plus, lorsqu’il identifie un problème potentiel, le service tente de valider l’exploitabilité de la découverte dans un environnement sandbox avant de la signaler. Cette étape de validation pourrait s’avérer révolutionnaire.

Les outils d’analyse statique traditionnels submergent souvent les développeurs de fausses alertes, c’est-à-dire de situations qui peuvent sembler à risque mais qui ne sont pas réellement exploitables. « Le principal avantage d’Aardvark est qu’il réduit considérablement les faux positifs », a souligné M. Jain. « Il est utile dans les codes open source et dans le cadre du pipeline de développement. » Une fois qu’une vulnérabilité est confirmée, Aardvark s’intègre à Codex pour proposer un correctif, puis réanalyse la correction afin de s’assurer qu’elle n’introduit pas de nouveaux problèmes. Le fournisseur affirme que lors de tests de référence, le système a identifié 92 % des vulnérabilités connues et introduites de manière synthétique dans les référentiels de test, ce qui laisse présager que l’IA pourrait bientôt prendre en charge une partie de la charge de travail liée à l’audit des codes modernes.

Sécuriser l’open source et déplacer la sécurité en amont

Le rôle de l’agent dépasse le cadre des environnements d’entreprise. OpenAI l’a déjà déployé dans des référentiels open source, où il affirme avoir découvert plusieurs vulnérabilités réelles, dont dix ont obtenu des identifiants CVE officiels. La société prévoit de fournir gratuitement des analyses pour certains projets open source non commerciaux, dans le cadre d’un système de divulgation coordonnée qui donne aux responsables le temps de corriger les failles avant leur publication. Cette approche s’inscrit dans le cadre d’une prise de conscience croissante du fait que la sécurité des logiciels n’est pas seulement un problème du secteur privé, mais une responsabilité partagée par l’ensemble de l’écosystème.

« La sécurité devenant de plus en plus importante et sophistiquée, ces agents de sécurité autonomes seront utiles aux grandes comme aux petites entreprises », a fait valoir Pareekh Jain. L’annonce d’OpenAI reflète également un concept plus large dans le secteur, connu sous le nom de « shifting security left » (déplacement de la sécurité vers la gauche), qui consiste à intégrer les contrôles de sécurité directement dans le développement, plutôt que de les traiter comme des tests de fin de cycle. « Avec plus de 40 000 vulnérabilités CVE signalées chaque année et un cycle de développement des logiciels attaquée en permanence, l’intégration de l’IA dans le flux de travail des développeurs pourrait contribuer à trouver un équilibre entre rapidité et vigilance », a estimé le fournisseur.