Présenté lors de la WWDC 2025 d’Apple, le framework Foundation Models apporte aux développeurs un accès privé et gratuit à l’IA sur les terminaux à la pomme.

L’intelligence artificielle sera le moteur des expériences technologiques futures et doit être considérée comme un outil utilitaire. C’est l’impératif stratégique qui a poussé Apple à présenter lors de la WWDC 2025, début juin, son framework Foundation Models pour ses systèmes d’exploitation. Il s’agit d’une série d’outils qui donneront aux développeurs la capacité d’exploiter les grands modèles linguistiques (LLM) dans leurs applications pour les plateformes de la firme de Cupertino. C’était l’une des nombreuses améliorations destinées aux développeurs annoncées par la société la semaine dernière. L’idée est que les développeurs pourront utiliser ces modèles avec seulement trois lignes de code. Ainsi, si vous souhaitez créer un éditeur CMS universel pour iPad, vous pouvez ajouter des outils d’écriture et des services de traduction à votre application afin d’aider les rédacteurs à produire des contenus de meilleure qualité destinés à un réseau international de sites multilingues. Mieux encore, lorsque vous créez cette application, ou toute autre application, la firme ne vous facturera pas l’accès à ses modèles Apple Intelligence de base, qui fonctionnent eux-mêmes sur le terminal. Cela signifie que les développeurs peuvent intégrer dans leurs applications une suite complète de fonctionnalités d’IA , tout en garantissant la confidentialité des utilisateurs.

Que sont les modèles de base ?

Dans une note publiée sur son site web destiné aux développeurs, Apple indique que les modèles mis à disposition dans le Foundational Models sont particulièrement performants pour les tâches de génération de texte telles que la synthèse, l’« extraction d’entités », la compréhension de texte, le raffinement, les dialogues pour les jeux, la génération de contenu créatif, etc.

Les bénéfices majeures :

– des outils Apple Intelligence en tant que service à utiliser dans vos applications ;

– de la confidentialité, car toutes les données restent sur le terminal ;

– La possibilité de travailler hors ligne, car le traitement s’effectue sur l’appareil.

– Des applications légères, car le LLM est intégré au système d’exploitation.

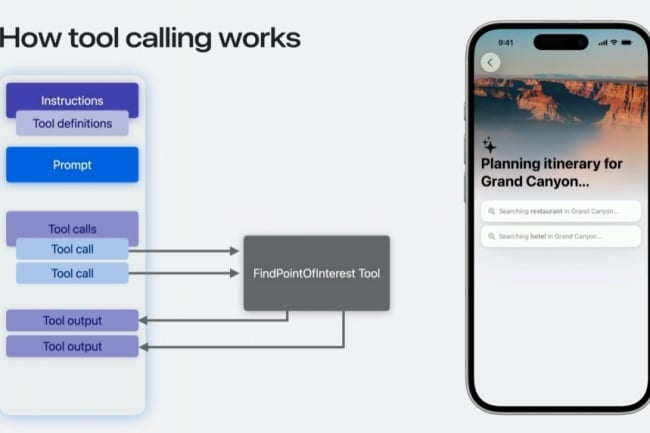

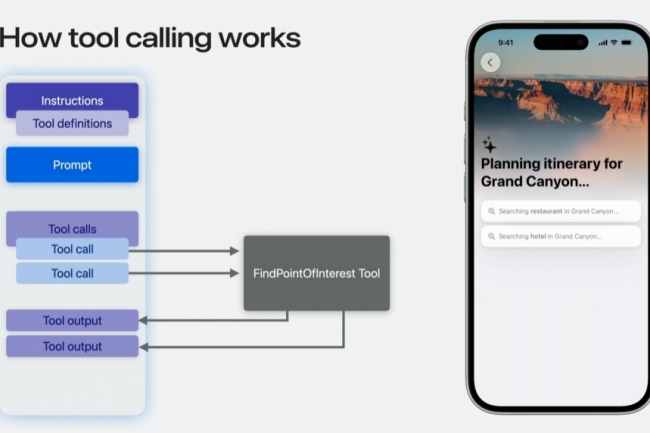

Apple a également pris des décisions judicieuses dans la manière dont il a conçu ses modèles fondamentaux. La génération guidée, par exemple, garantit que le LLM fournit des réponses structurées de manière cohérente pour une utilisation dans les applications que vous créez, plutôt que le code désordonné généré par de nombreux LLM. Le framework d’Apple est également capable de fournir des réponses complexes dans un format plus exploitable. Enfin, la firme a déclaré qu’il était possible de donner au LLM Apple Intelligence accès à d’autres outils que les vôtres. Le magazine Dev explique que le « tool calling » (appel d’outils) signifie que vous pouvez indiquer au LLM quand il doit utiliser un outil externe pour obtenir des informations, telles que les prévisions météorologiques en temps réel. Cela peut également s’étendre à des actions telles que la réservation de voyages.

Ce type d’accès à des informations réelles permet de garder le LLM sobre, en l’empêchant d’utiliser de fausses données pour résoudre sa tâche. Enfin, la société a également trouvé le moyen de faire en sorte que les applications se souviennent des conversations de l’IA, ce qui signifie que vous pouvez engager des sessions de demandes inclusives, plutôt que des demandes à usage unique. Afin de stimuler le développement à l’aide des modèles de base, Apple a intégré une prise en charge de cette fonctionnalité dans Xcode Playgrounds.

Relancer Siri

Apple Intelligence a toutefois ses détracteurs. La plupart des critiques reposent sur l’idée que la plateforme GenAI doit être un chatbot intelligent comme ChatGPT (et il n’est pas du tout injuste de critiquer Siri pour être l’ombre de ce qu’il était censé être). Mais cette focalisation sur Siri occulte la valeur plus substantielle que l’utilisation des LLM apporte à des tâches spécifiques, telles que les outils d’écriture déjà mentionnés. Oui, Siri est insuffisant (mais en voie d’amélioration) et le développement d’Apple Intelligence a été très embarrassant pour l’entreprise. Mais cela ne signifie pas que tout ce qui concerne l’IA d’Apple est mauvais, ni qu’elle ne s’améliorera pas avec le temps.

La firme a compris qu’en rendant ces modèles d’IA accessibles aux développeurs et aux applications tierces, elle permet à ceux qui n’ont pas les moyens de s’offrir des LLMs payants d’être créatifs avec l’IA. C’est une avancée considérable, qui pourrait être considérée comme un « moment iPhone », ou du moins un « moment App Store », à part entière, et qui devrait permettre de nombreuses expérimentations. « Nous pensons que cela va déclencher une toute nouvelle vague d’expériences intelligentes dans les applications que les utilisateurs utilisent quotidiennement », a déclaré Craig Federighi, vice-président senior d’Apple chargé de l’ingénierie logicielle, lors de la WWDC 2025. « Nous sommes impatients de voir ce que les développeurs vont créer. »

Vers une IA omniprésente et transparente

Pour le meilleur ou pour le pire, nous savons que l’IA sera partout, l’important est de déterminer comment se positionner au mieux pour s’adapter à cette réalité. Permettre aux développeurs d’intégrer facilement et gratuitement l’IA dans leurs applications signifie qu’ils pourront expérimenter et, espérons-le, tracer leur propre voie. Cela signifie également qu’Apple a considérablement réduit les barrières à l’entrée pour le développement de l’IA sur ses plateformes, alors même qu’elle s’efforce de toute urgence d’élargir l’éventail des modèles d’IA qu’elle propose dans Apple Intelligence. À mesure que de nouveaux modèles de base seront introduits, les développeurs pourront les utiliser, ce qui favorisera l’expérimentation. Avec un coût pour la confidentialité et un coût d’entrée fixés à zéro, les modèles de base changent le débat autour de l’IA sur les plateformes Apple. Il ne s’agit pas seulement d’un Siri plus pertinent mais d’un écosystème plus efficace pour Apple grâce à la contribution des développeurs.

Le framework des modèles de base est disponible en version bêta pour les développeurs qui disposent déjà de versions bêta publiques, et sera livré avec les systèmes d’exploitation en juillet.