Lors du sommet OCP, du 13 au 16 octobre 2025 à San Jose en Californie, Arm a indique qu’il se concentrera sur les normes d’infrastructure à haut rendement pour les centres de données IA.

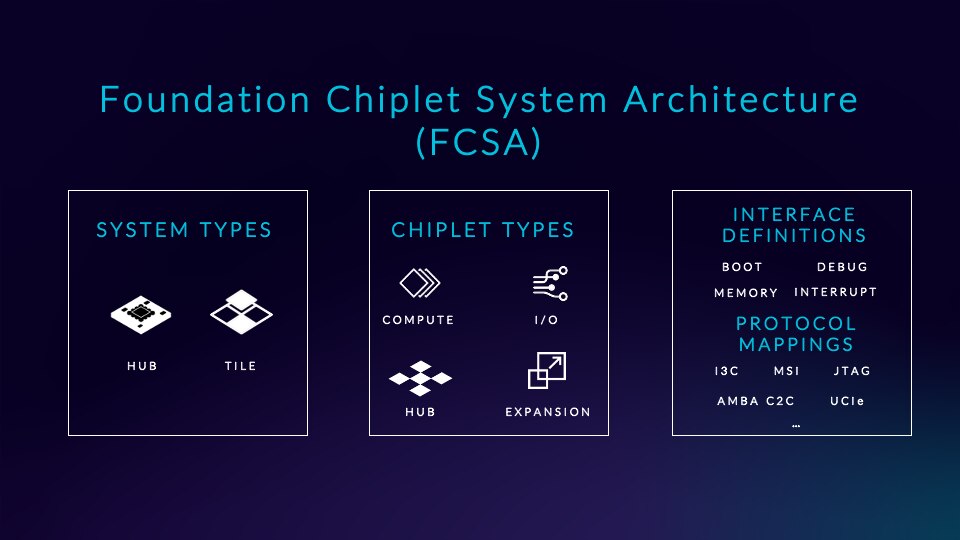

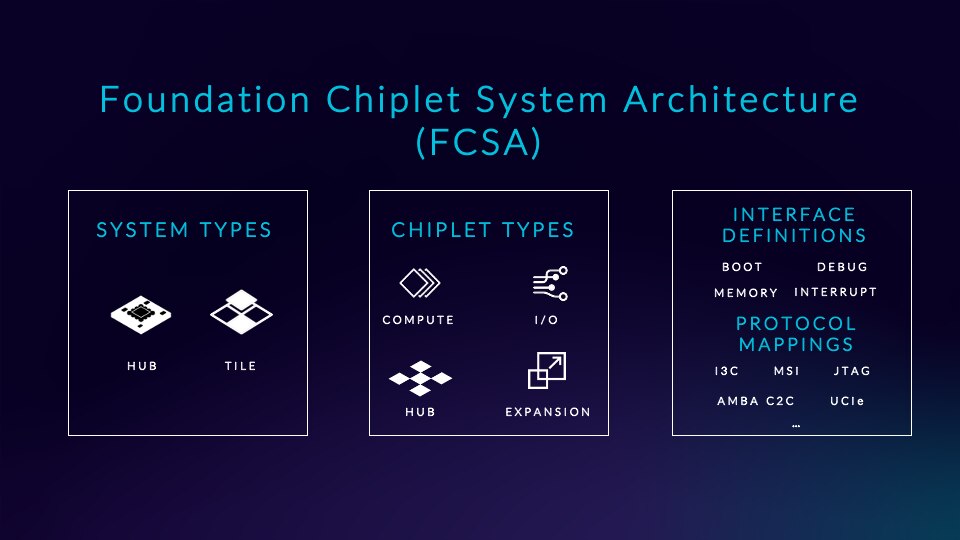

Le concepteur de puces Arm a annoncé son adhésion à l’Open Compute Project afin de contribuer à répondre à la demande énergétique croissante des centres de données orientés IA. Le britannique a déclaré qu’il prévoyait d’aider les fournisseurs à développer la prochaine génération de puces et de serveurs spécialement conçus pour les infrastructures convergentes. Le développement de cette nouvelle génération nécessite des capacités de co-conception dans les domaines du calcul, de l’accélération, de la mémoire, du stockage, des réseaux et bien plus encore. Les datacenters IA convergents ne seront pas architecturés comme auparavant, avec des CPU, GPU, réseaux et mémoires séparés. Selon Arm, ils offriront une densité accrue grâce à l’intégration sur mesure de plusieurs chiplets dans une même puce à l’aide des technologies 2,5D et 3D. La société répond à cette demande en contribuant à la spécification FCSA (Foundation Chiplet System Architecture) de l’Open Compute Project. La FCSA s’appuie sur les travaux en cours d’Arm avec l’Arm Chiplet System Architecture (CSA), mais répond à la demande du secteur pour un cadre qui s’aligne sur les exigences neutres des fournisseurs et de l’architecture des processeurs.

Pour équiper la prochaine génération de serveurs convergents, le groupe apporte sa spécification Foundation Chiplet System Architecture à l’OCP et élargit son écosystème Total Design. Selon Mohamed Awad, vice-président senior et directeur général de la division Infrastructure chez Arm, les avantages pour les partenaires OEM sont l’efficacité énergétique et la conception personnalisée des processeurs. « Pour quiconque construit un centre de données, le défi spécifique auquel il est confronté n’est pas vraiment lié au coût de la construction, mais plutôt à la nécessité de répondre à la demande [en énergie] », a-t-il déclaré. Répondre à la demande revient à améliorer les performances, et plus précisément les performances par watt. Avec une alimentation limitée, les OEM s’impliquent beaucoup plus dans tous les aspects de la conception du système, plutôt que de se contenter d’acheter des puces, des serveurs ou des racks prêts à l’emploi. « Ils sont beaucoup plus précis quant à l’aspect de ces puces, ce qui représente un changement radical par rapport à la situation des centres de données il y a dix ou quinze ans. Le but est ici de créer une conception de système plus optimisée afin de rapprocher l’accélération du calcul et d’obtenir de bien meilleures performances par watt », a déclaré M. Awad.

Les chiplets ouvrent de nouvelles opportunités pour la co-conception de puces avec plusieurs fournisseurs. (Crédit Arm)

Un OCP Summit réunissant les principaux fournisseurs d’infrastructures

L’Open Compute Project est une organisation industrielle mondiale qui se consacre à la conception et au partage de configurations matérielles open source pour les technologies et les infrastructures des centres de données. Elle couvre tout, des produits en silicium à la conception des racks et des plateaux. Elle organise cette semaine son sommet mondial OCP 2025 (du 13 au 16 octobre 2025 à San Jose en Californie). Arm a également participé à l’initiative Ethernet for Scale-Up Networking (ESUN) annoncée cette semaine lors du sommet, qui comprenait AMD, Arista, Broadcom, Cisco, HPE Networking, Marvell, Meta, Microsoft et Nvidia. ESUN promet de faire progresser la technologie de réseau Ethernet afin de gérer la connectivité à grande échelle dans les infrastructures d’IA accélérées.

En rejoignant l’OCP, Arm vise à encourager le partage des connaissances et la collaboration entre les fournisseurs IT et les entreprises clientes afin de partager des idées, des spécifications et la propriété intellectuelle. Le britannique est connu pour privilégier les conceptions modulaires plutôt que monolithiques, d’où l’intérêt des chiplets. Par exemple, les clients peuvent faire appel à plusieurs entreprises différentes pour construire un processeur à 64 cœurs, puis choisir l’interface d’E/S à associer, qu’il s’agisse de PCIe ou de NVLink. Ils choisissent ensuite leur propre sous-système de mémoire, en décidant d’opter pour de la HBM, LPDDR ou DDR. Tout cela s’assemble comme des Legos, explique M. Awad. « Ce modèle permet de sélectionner ces composants de manière différenciée, là où cela a du sens, sans avoir à refaire tous les autres aspects du système qui sont en fait communs à plusieurs conceptions différentes », explique M. Awad.