Pour exécuter les workload analytiques dans son cloud, Snowflake lance Snowpark Connect pour Apache Spark. Ce service promet de réduire la latence et la complexité en déplaçant les tâches analytiques au plus proche des données.

Le framework de développement Snowpark de Snowflake s’étoffe. Après le service pour les conteneurs ou pou Python, c’est au tour des workload analytiques d’être mis en avant avec Connect for Apache Spark. L’objectif est d’exécuter ces tâches directement dans Data Cloud de Snowflake ce qui évite aux entreprises d’avoir à héberger une instance Apache Spark ailleurs et leur épargne des délais de transfert de données. Cette offre en preview publique s’appuie sur Spark Connect, une fonctionnalité introduite dans la version 3.4 du projet open source. Elle facilite l’exécution du code des utilisateurs séparément du cluster Apache Spark qui prend en charge les workload les plus lourds.

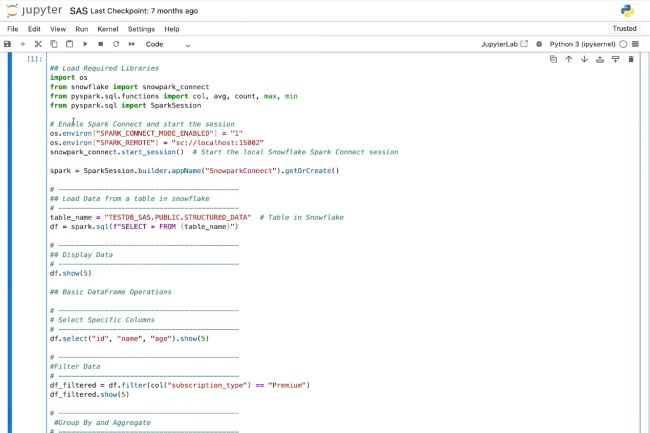

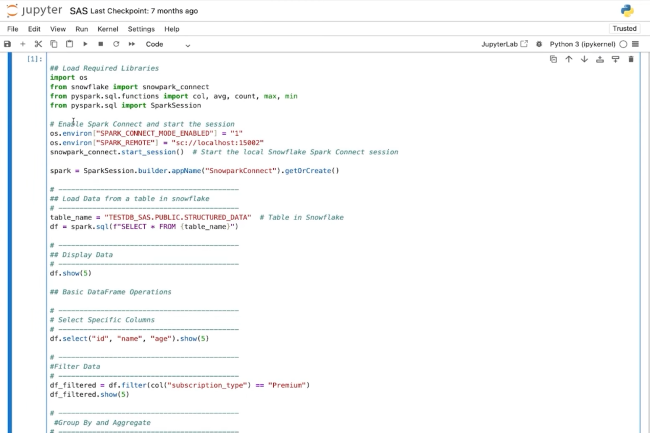

Avec Spark Connect, « l’application, que ce soit un script Python ou un notebook de données, envoie simplement le plan logique non résolu à un cluster Spark distant. Celui-ci effectue tout le gros du travail et renvoie les résultats », a expliqué Snowflake dans un article de blog. L’intégration de cette fonction au sein de Snowpark donne « aux développeurs la capacité de transférer facilement leur code vers Snowpark, et de bénéficier ainsi de la familiarité de Spark et de la simplicité de Snowflake », selon Sanjeev Mohan, analyste en chef chez SanjMo. Il ajoute, « les entreprises pourront aussi réduire le TCO (coût total de possession), car les développeurs pourront tirer parti du moteur serverless de Snowflake et n’auront plus besoin de régler Spark ».

Risque de confusion

Parmi les autres avantages, ce dernier cite un traitement plus rapide grâce au moteur vectorisé du fournisseur, mais aussi le fait que l’entreprise n’aura pas à se mettre en quête d’un personnel ayant une expertise Spark. Shubham Yadav, analyste senior chez Everest Group, estime que ce lancement arrive à point nommé, car les entreprises cherchent à simplifier leur infrastructure et à réduire leurs coûts dans un contexte d’adoption croissante de l’IA et du machine learning.

Mais attention, les entreprises doivent faire attention de ne pas confondre Snowpark Connect pour Apache Spark avec Snowflake Connector pour Spark. Ce dernier s’apparente à un pont entre les deux solutions où les données peuvent circuler dans les deux sens. Le premier est plus un transfert de l’ensemble de l’instance Spark au sein du Data Cloud de Snowflake. La différence entre les deux se traduit par une latence et un coût plus élevés pour le transfert de données via Connector. Selon le spécialiste du datastore, il est possible de migrer de Connector à Snowpark Connect sans avoir à convertir le code. A noter que Databricks propose aussi ce type de fonctionnalité avec son offre Connect.