Dans la guerre des assistants à base d’IA, il faudra maintenant compter sur Meta AI. L’application mobile basée sur Llama 4 promet une expérience plus fluide, interactive et personnalisée.

Après avoir intégré son assistant IA à ses diverses plateformes, Meta franchit une étape avec le lancement d’une application mobile autonome. Meta AI centralise un large éventail d’interactions avec l’assistant, donnant ainsi la capacité aux utilisateurs de gérer plusieurs tâches sur un seul outil. Motorisée par le modèle Llama 4, l’application de GenAI veut proposer une expérience plus fluide, interactive et personnalisée. Disponible sur iOS et Android, elle est accessible en France sur le Play Store et l’App Store.

Pensé pour être intuitif, l’assistant intègre des fonctionnalités vocales avancées reposant sur un modèle de synthèse générée directement à partir de dialogues conversationnels, loin de la simple lecture de texte. Le mode full-duplex, activable sur demande, propose à l’utilisateur d’interrompre l’IA à tout moment, comme dans une conversation téléphonique. Cette approche rend les échanges plus naturels, bien que la fonction reste pour l’instant déconnectée des informations en temps réel. Par ailleurs, l’assistant peut rester actif en arrière-plan, même lorsque l’utilisateur utilise d’autres applications, avec une icône discrète indiquant que le microphone est en usage.

Une IA personnalisée

Avec cette version, la plateforme mise sur une IA plus contextualisée et proactive. L’assistant peut désormais mémoriser certaines préférences ou centres d’intérêt de l’utilisateur comme les voyages, l’apprentissage des langues ou la lecture afin d’adapter ses réponses de manière plus pertinente. En se connectant aux comptes Facebook et Instagram, Meta AI est également capable d’exploiter, avec l’accord de l’utilisateur, les contenus partagés ou consultés pour affiner encore davantage ses interactions.

Au-delà de la personnalisation, Meta introduit une fonction d’interaction avec un onglet Discover. Celui-ci donne la possibilité aux utilisateurs de partager les prompts qu’ils soumettent à l’IA ainsi que les réponses obtenues. Ces échanges sont publiés sous forme de posts dans un fil dédié, où d’autres utilisateurs peuvent les commenter, les aimer, ou encore réutiliser les prompts proposés. Une manière pour Meta d’encourager l’émulation entre utilisateurs et d’enrichir les usages collaboratifs de son assistant.

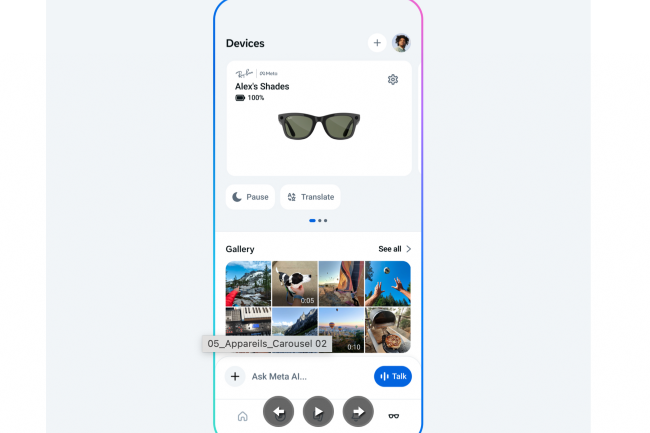

L’intégration avec les lunettes Ray-Ban Meta

Pour renforcer l’expérience multi-plateformes, l’application Meta AI s’intègre désormais aux lunettes Ray-Ban Meta, développées en partenariat avec EssilorLuxottica. Ces lunettes connectées, équipées de micros et de caméras, offrent à l’IA la capacité de « voir » et d' »entendre » l’environnement de l’utilisateur, facilitant ainsi les interactions vocales en temps réel.

La firme américaine a également fusionné l’application Meta AI avec l’application View, dédiée aux lunettes connectées. Ainsi, les utilisateurs peuvent commencer une conversation sur leurs lunettes, puis la poursuivre sur l’application mobile ou via l’interface web. Cette interconnexion permet une fluidité inédite entre différents appareils. Si la transition inverse, du mobile vers les lunettes n’est pas encore disponible, Meta vise à fluidifier l’expérience entre les différents supports. Les fonctionnalités déployées aux États-Unis seront progressivement étendues à d’autres marchés internationaux.

Les lunettes Ray-Ban Meta, reliées à Meta AI, facilitent les échanges vocaux grâce à leurs micros et caméras intégrés. (Crédit photo: Meta)