En instaurant des limites d’usage concernant le nombre de requêtes d’IA dans ses outils de codage les plus évolués, l’évolution de la tarification de Github reflète la transition de l’industrie vers des modèles d’affaires durables et surtout plus rentables.

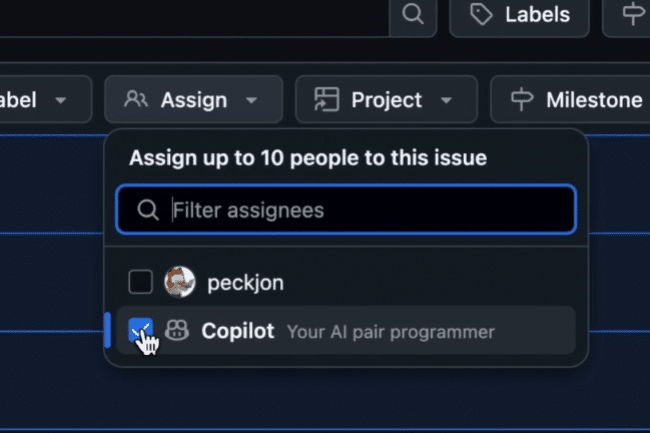

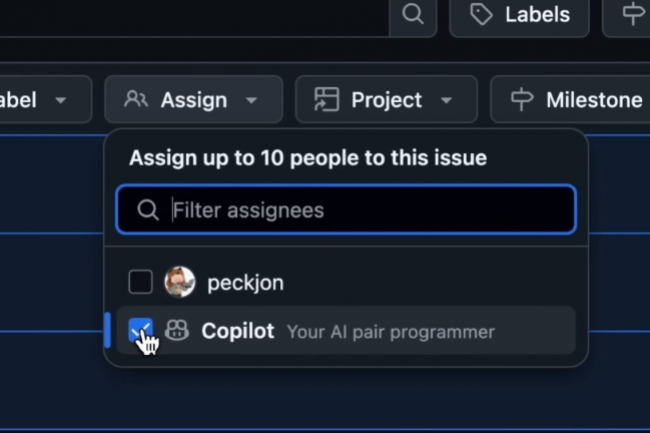

Dans la foulée d’autres entreprises d’IA qui ont fait passer les utilisateurs de services gratuits ou illimités à des niveaux d’abonnement payants une fois l’adoption établie, Github a commencé à appliquer cette semaine des limites mensuelles à ses modèles de codage d’IA les plus performants. « Les limites mensuelles de requêtes premium pour les utilisateurs payants de Copilot sont désormais en vigueur », a déclaré le référentiel à propos de la facturation de son outil, confirmant que le tarif des requêtes supplémentaires commençait désormais à 0,04 $HT chacune. Cette mise en application est conforme aux restrictions annoncées par le CEO de Github, Thomas Dohmke, en avril. La mesure affecte les utilisateurs des modèles d’IA les plus avancés de Github, notamment Claude 3.5 et 3.7 Sonnet d’Anthropic, Gemini 2.0 Flash de Google et o3-mini d’OpenAI. « Les utilisateurs qui dépassent leurs allocations mensuelles doivent dorénavant attendre le prochain cycle de facturation ou activer la facturation à la demande pour continuer à utiliser les fonctionnalités premium », ajoute le billet de blog.

Des requêtes premium différenciées selon le plan

Ces restrictions créent un accès différencié aux capacités avancées de l’IA. Les clients de Copilot Pro auront droit à 300 requêtes premium mensuelles, tandis que les utilisateurs de Copilot Business et Enterprise auront droit à 300 et 1.000 requêtes respectivement. Github proposera également un plan Pro+ à 39 dollars HT par mois, incluant 1.500 requêtes premium et l’accès à ce que l’entreprise décrit comme « les meilleurs modèles, comme GPT-4.5 ». Chaque modèle consomme des requêtes premium sur la base d’un système de multiplicateur qui reflète les coûts de calcul. GPT-4.5 a un multiplicateur de 50x, ce qui signifie qu’une interaction compte pour 50 demandes premium, alors que Gemini 2.0 Flash de Google n’utilise qu’un multiplicateur de 0,25x. Les utilisateurs peuvent toujours faire des requêtes illimitées en utilisant le modèle de base GPT-4o de Github, bien qu’une limitation s’applique en cas de forte demande. Pour ceux qui dépassent les allocations mensuelles, le système de facturation actuel de Github demandera aux utilisateurs de « définir une limite de dépenses dans leurs paramètres de facturation » avec « la limite par défaut fixée à 0 dollar », ce qui signifie que les demandes supplémentaires seront rejetées à moins qu’elles ne soient explicitement autorisées.

Lors de l’annonce préliminaire du système de requêtes premium en avril, Thomas Dohmke avait justifié ces restrictions par la nécessité de rendre durables les services d’IA de la plateforme. « Depuis Github Universe, nous avons introduit un certain nombre de nouveaux modèles pour le chat, les éditions multi-fichiers et maintenant le mode agent. Avec la disponibilité générale de ces modèles, nous introduisons un nouveau type de demande premium », avait déclaré alors le CEO. L’application des limites dans les requêtes premium de Copilot avait été retardée en mai. Github avait expliqué qu’elle souhaitait que « les utilisateurs puissent voir facilement combien de demandes de primes ils utilisaient et leur donner le contrôle sur leurs limites et leurs dépenses potentielles. »

Vive réaction des développeurs dans toute l’industrie

Pour les entreprises clientes, ces changements signalent la maturation des outils d’IA, qui passent du statut de technologies expérimentales à celui de services commerciaux essentiels nécessitant une planification budgétaire et un approvisionnement stratégique. Le système de facturation actuel de Github permet aux entreprises de « surveiller l’utilisation des demandes premium en temps réel à partir de l’icône d’état Copilot dans l’IDE ou de télécharger des rapports d’utilisation détaillés », mais toutes les demandes premium dépassant les allocations mensuelles sont rejetées à moins que les administrateurs n’activent explicitement la facturation supplémentaire. L’application de cette mesure a également suscité des plaintes de la part des utilisateurs de Github Copilot sur les forums en ligne, les discussions de la communauté montrant que presque tous les commentaires postés au cours de la semaine dernière soutiennent que les limites sont beaucoup trop basses et semblent délibérément forcer les clients à passer à des plans d’abonnement plus coûteux. « 300 requêtes premium par jour, c’est bien, mais par mois, c’est ridicule », a écrit un utilisateur sur la page du forum. Ce genre de critique est caractéristique de l’industrie de l’IA, quand des services devenus matures entrent dans le cycle de la rentabilité.

Ce changement s’est matérialisé dans différentes catégories de services d’IA, créant un modèle cohérent de réduction de l’accès gratuit à mesure que les plateformes établissent leur présence sur le marché. Midjourney illustre parfaitement cette tendance. Initialement, lors de son lancement en juillet 2022, le populaire créateur d’images par IA offrait 25 images gratuites aux nouveaux utilisateurs, mais en juin 2023, les essais gratuits ont été entièrement supprimés, exigeant des abonnements payants à partir de 10 dollars HT par mois. La plateforme de génération de vidéos Runway AI structure son offre autour d’un système de crédits où le niveau gratuit ne fournit qu’un « dépôt unique de 125 crédits », tandis que les abonnements payants à partir de 15 dollars HT par mois offrent des allocations de crédits renouvelables qui « ne sont pas reportées sur les mois suivants ». Les services d’IA conversationnelle ont mis en place des restrictions similaires. Claude d’Anthropic impose des limites de messages quotidiens aux utilisateurs gratuits, autorisant généralement 40 à 50 messages par jour, tandis que le niveau gratuit de ChatGPT restreint les utilisateurs aux anciens modèles GPT-3.5 avec des limitations d’accès pendant les périodes d’utilisation intensive.

Les pressions sur les revenus favorisent la monétisation

La tendance à la monétisation reflète la pression croissante exercée sur les entreprises d’IA pour qu’elles présentent des modèles commerciaux durables. Selon TechCrunch, le CEO de Microsoft, Satya Nadella, a déclaré en août dernier que Copilot représentait plus de 40 % de la croissance du chiffre d’affaires de Github en 2024 et qu’il représentait déjà « une activité plus importante que l’ensemble de Github lorsque le géant de la technologie l’a acquis il y a environ sept ans ». La formation et l’exploitation de modèles de langage avancés nécessitent des ressources informatiques considérables, les principales entreprises d’IA dépensant des centaines de millions de dollars en infrastructure. Le financement par capital-risque devenant plus sélectif et les investisseurs exigeant des débouchés plus clairs vers la rentabilité, les entreprises d’IA s’appuient de plus en plus sur les revenus d’abonnement plutôt que sur des stratégies de croissance non viables.

L’approche de Github reflète ce recalibrage plus large. « Les requêtes premium s’ajoutent aux demandes illimitées pour le mode agent, le chat contextuel et les complétions de code dont bénéficient tous les plans payants dans le cadre de notre modèle de base », a souligné l’entreprise dans son annonce d’avril, positionnant les changements comme des services à valeur ajoutée plutôt que comme des restrictions sur les fonctionnalités de base. Cette tendance suggère que les DSI et les responsables technologiques devraient se préparer à des changements similaires dans leurs portefeuilles d’outils d’IA. À mesure que ces services passent du statut d’offres subventionnées par le capital-risque à celui d’entreprises autonomes, les entreprises devront peut-être réévaluer leurs stratégies d’IA et leurs allocations budgétaires en conséquence.