A l’occasion du Google Cloud Security Summit, le fournisseur a présenté des fonctionnalités pour aider les développeurs à détecter et à protéger les agents IA.

Après avoir mis le cap sur les agents IA à l’occasion de son évènement Next en mai dernier, Google Cloud se focalise maintenant sur leur sécurité. Le fournisseur a présenté différentes fonctionnalités allant dans ce sens lors du Security Summit organisé en virtuel. Dans un échange avec Network World , Naveed Makahani, responsable produit pour la sécurité et l’IA chez Google Cloud a expliqué que l’une des plus importantes améliorations concerne la solution AI Protection (qui fait partie du GCP (Google Cloud Platform) Security Command Center). « Alors que les entreprises adoptent rapidement l’IA, nous développons des fonctionnalités pour aider les entreprises à sécuriser leurs initiatives », a-t-il ajouté. C’est notamment le cas des fonctionnalités de détection automatisée des agents IA et des serveurs MCP (Model Context Protocol) dans Security Command Center.

« Grâce à cette mise à jour, bientôt disponible en test, les défenseurs pourront identifier automatiquement les vulnérabilités, les erreurs de configuration et les interactions à haut risque dans leur écosystème d’agents IA ; se défendre contre les risques d’exécution spécifiques aux agents, tels que l’empoisonnement des outils et l’injection indirecte de commandes », constate le responsable. Il ajoute que « l’objectif est d’améliorer la réponse aux incidents pour les comportements à risque et les menaces externes, tels que la détection de comportements anormaux et suspects sur les actifs des agents ». Les fonctionnalités annoncées contribueront aussi à renforcer la mise en œuvre d’un SOC à base d’agents IA (Agentic SOC) que les clients peuvent créer via GCP. Ce centre donnera aux agents IA la possibilité de coordonner leurs actions pour atteindre un objectif commun. « Un SOC avec des agents peut augmenter considérablement la productivité des analystes et des ingénieurs en sécurité, qui pourront ainsi consacrer plus de temps aux menaces importantes », avance Naveed Makahani.

Evolutions au sein de Security Command Center

Au sein de Security Command Center, Google Cloud a dévoilé plusieurs évolutions. Parmi elles, on retrouve Compliance Manager actuellement en test. Il unifie la définition des politiques, la configuration des contrôles, l’application, la surveillance et la génération de preuves pour l’audit afin de rationaliser les workflows de sécurité, de confidentialité et de conformité sur Google Cloud. De plus, les contrôles recommandés de l’IA automatisent la conformité des charges de travail d’IA grâce à des références intégrées, des contrôles spécifiques à l’IA, des rapports et une surveillance continue.

Un autre élément est Data Security Posture Management, lui aussi disponible en test. Il assure la gouvernance de la sécurité et de la conformité des données sensibles. A noter que l’intégration native avec BigQuery Security Center offre aux professionnels des données de surveiller la sécurité et la conformité de leurs données directement dans leur console BigQuery sans changer de contexte. Enfin, Risk Reports (aussi en test) met en évidence et résume les problèmes de sécurité cloud qui peuvent exposer une entreprise à des risques d’attaque. Grâce à la red team virtuelle du Security Command Center, les rapports sur les risques peuvent être utilisés aussi bien par les équipes de sécurité que par les équipes métiers pour identifier et corriger rapidement les failles dans les défenses cloud.

De la gestion d’identité pour les agents IA

Sur la partie identité, Google Cloud oriente ses fonctions vers l’IA. C’est le cas d’Agentic IAM, qui sera disponible plus tard cette année. Il offrira aux utilisateurs d’activer les identités des agents d’IA dans tous les environnements cloud. Le service allouera automatiquement les identités de agents IA dans tous les environnements d’exécution de développement d’agents et prendra en charge un large éventail de types d’identifiants, de politiques d’autorisation et d’observabilité de bout en bout. La fonction Role Picker (en preview) donne aux administrateurs la possibilité d’accorder un accès avec le moins de privilèges possible à l’aide du chatbot Gemini. Ils pourront ainsi décrire l’action souhaitée (ou plusieurs actions) et Gemini recommandera instantanément le rôle le plus approprié et le moins permissif pour les identités humaines et non humaines.

Enfin, une fonction de réauthentification des actions sensibles est disponible en test. Elle se déclenchera lors d’accès à des documents sensibles comme la mise à jour des comptes de facturation. Activée par défaut, Google Cloud recommande vivement de la laisser activée afin d’éviter tout accès non autorisé et toute compromission potentielle des comptes sensibles.

Sécurité des données et du réseau renforcée

Concernant la protection des données, la fonction Sensitive Data Protection est étendue pour surveiller le générateur d’agents Vertex AI ainsi que les ressources liées à l’IA dans BigQuery et CloudSQL. Elle inspectera également les images à la recherche de données sensibles telles que les codes-barres et les numéros de plaque d’immatriculation, et détectera les modèles contextuels d’IA et d’apprentissage machine pour les dossiers médicaux, les factures financières et les types de code source. L’offre Cloud Key Management System Autokey in Cloud Setup va aider les clients qui ont besoin de leurs propres clés de chiffrement à s’intégrer plus rapidement grâce à une mise en conformité immédiate avec les pratiques de gestion des clés recommandées.

Pour l’aspect réseau, une extension des tags Cloud NGFW (next gen firewall) à ceux présents au sein de l’entreprise. Par ailleurs, Cloud NGFW pour les réseaux RDMA, désormais en test, promet une mise en réseau de type zero trust pour les clouds privés virtuels (VPC) de HPC, y compris les charges de travail IA dans Google Cloud. Enfin, Cloud Armor un service de sécurité qui protège les applications et les sites web contre les attaques par déni de service distribué (DDoS) et d’autres menaces a été mis à jour. Une version Enterprise est disponible pour centraliser le contrôle et la protection automatique des projets dans Google Cloud. Sur le plan technique, le service a fait évolué les limites d’inspection pour les règles WAF et ajouté la prise en charge de la limitation de débit par empreintes JA4 et des informations sur les menaces basées sur l’ASN pour les réseaux de diffusion de contenu multimédia.

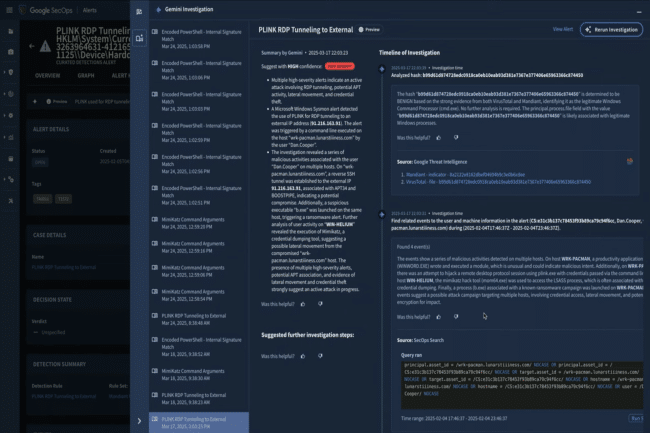

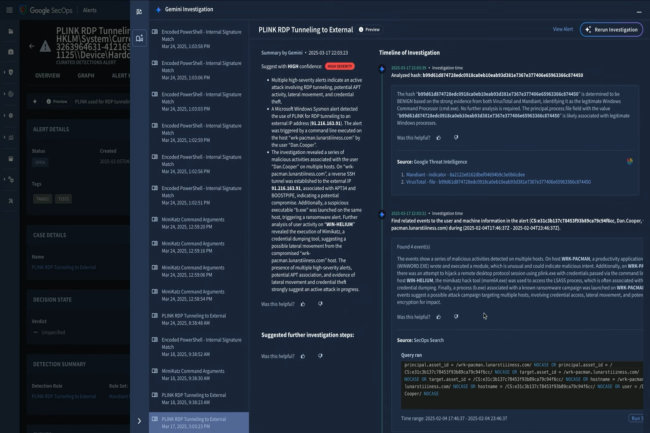

Un SecOps Labs créé et des tableaux de bord supplémentaires

La solution Unified Security basée sur l’IA s’étoffe en intégrant des informations sur les menaces, des opérations de sécurité, la sécurité dans le cloud et la navigation sécurisée en entreprise. Un SecOps Labs est mis à disposition des clients pour que les développeurs puissent accéder à des expériences basées sur l’IA pour l’analyse, la détection et la réponse. De même, le fournisseur a enrichi les tableaux de bord avec l’intégration native des données SOAR. Ils aident les administrateurs à visualiser, analyser et agir sur les données de sécurité.

« Notre dynamisme dans le domaine de la sécurité basée sur l’IA aidera les entreprises à redéfinir leur posture de sécurité et à réduire au maximum les risques liés à leurs investissements », a estimé Naveed Makhani. « Ces annonces contribueront à stimuler les opérations de sécurité et aideront les entreprises à gagner en efficacité opérationnelle, que ce soit pour détecter les vulnérabilités, traiter en quelques secondes de vastes quantités de données sur les menaces ou aider les équipes de sécurité à atteindre des niveaux de défense et d’efficacité sans précédent. » Selon Google, le tarif des nouvelles fonctionnalités est variable, certaines étant disponibles sans frais supplémentaires.

Une vigilance sur les avantages réels des fonctions de sécurité

Cependant, Joseph Steinberg, expert américain en cybersécurité et en IA, invite les professionnels de la sécurité de l’information de réserver leur jugement sur l’efficacité de ces fonctionnalités jusqu’à ce qu’elles soient utilisées dans le monde réel. « Nous avons constaté à maintes reprises qu’il existe un écart considérable entre les avantages théoriques d’une technologie de sécurité et la valeur qu’elle apporte réellement dans le monde réel », a-t-il déclaré par courriel.

« De plus, la sécurité suit un modèle différent de celui de la fonctionnalité. Par exemple, nous savons comment tirer parti d’une IA imparfaite qui améliore la productivité, nous savons comment l’utiliser de manière à améliorer la productivité tout en tenant compte des erreurs de l’IA, si bien que, en cas de défaillance, l’impact n’est généralement pas dévastateur. Par contre, les conséquences d’une technologie de sécurité imparfaite qui échoue ne serait-ce qu’une seule fois en mode « fail-to-allow », peuvent être très différentes. »