Le dernier modèle d’IA vocale d’OpenAI prend en charge les protocoles MC et SIP. Les entreprises pourront ainsi créer des agents vocaux autonomes et multimodaux.

Présenté récemment, le modèle d’IA audio GPT-realtime a intégré via son API le support de MCP (model context protocol) et SIP (session initiation protocol). Sur le premier, cette prise en charge « va permettre aux développeurs de programmer des agents vocaux pour accéder à des fonctionnalités et des outils externes répertoriés comme serveurs MCP sur Internet ou sur un autre serveur », a déclaré Charlie Dai, vice-président et analyste principal chez Forrester. Les serveurs MCP distants ne sont pas répertoriés localement là où l’agent ou l’application agentique est exécutée. « Les entreprises peuvent activer la prise en charge MCP dans une session API en transmettant l’URL d’un serveur MCP distant dans la configuration de la session », a indiqué OpenAI.

« Une fois connectée, l’API gère automatiquement les appels de l’outil pour l’utilisateur, il n’est donc pas nécessaire de réaliser manuellement les intégrations. Cette configuration facilite l’extension de l’agent avec de nouvelles fonctionnalités », a expliqué l’entreprise dans un article de blog. « Par ailleurs, avec l’ajout du support du protocole SIP, une norme permettant d’initier et de gérer des appels vocaux en temps réel sur les réseaux IP, les entreprises pourront intégrer directement des agents vocaux d’IA aux systèmes PBX et aux réseaux téléphoniques », a précisé M. Dai. Parmi les exemples d’utilisation pour lesquels les entreprises pourront tirer parti du support du protocole SIP dans l’API, celui-ci cite le traitement automatisé des appels, la prise de rendez-vous et l’assistance multilingue pour les services clients dans les centres de contact.

Entrée d’images et fonctionnalités supplémentaires

Afin de rendre le modèle gpt-realtime plus efficace pour les cas d’usage vocaux, OpenAI a ajouté la prise en charge des images, ce qui signifie que les utilisateurs peuvent désormais inclure des éléments visuels, comme des photos, des captures d’écran ou d’autres images, en plus du texte ou de l’audio dans une session, de sorte que le modèle peut interpréter et répondre en fonction de ce qui est présenté visuellement. Dans son blog, OpenAI explique qu’il devient ainsi possible de poser des questions comme « Que voyez-vous ? » ou « Pouvez-vous lire le texte dans cette image ? ». Selon les analystes, la possibilité d’entrer des images est un excellent ajout qui sera très utile aux entreprises. « On peut considérer ça comme une prise en charge multimodale, qui est un domaine clé du marché », a convenu M. Dai, ajoutant que des concurrents comme Google avec Project Astra se concentrent également sur l’assistance multimodale en temps réel.

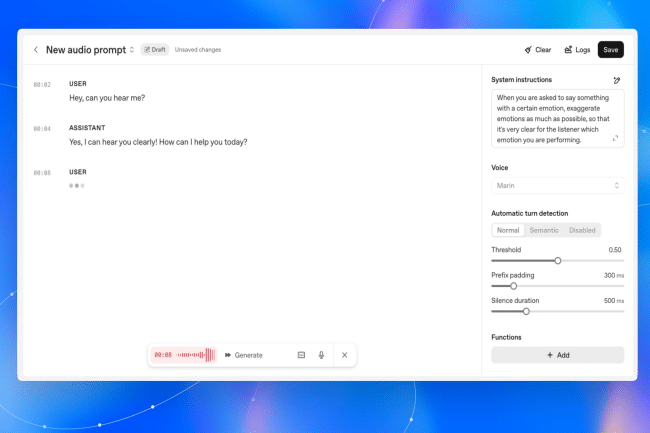

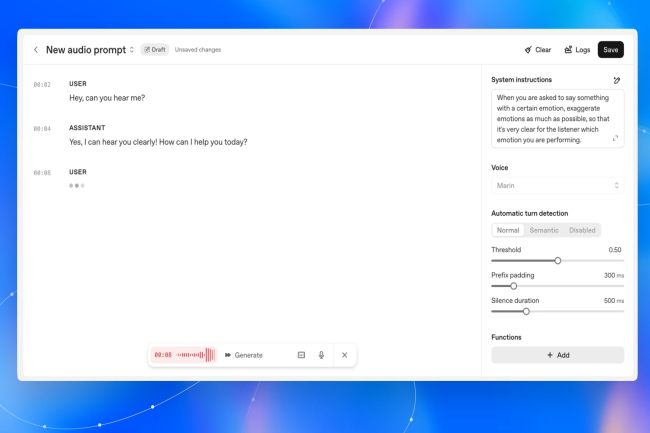

Outre l’ajout de la saisie d’images comme fonctionnalité, OpenAI a amélioré la reconnaissance du contexte et la mémoire du modèle gpt-realtime. De plus, le fournisseur du modèle affirme que le modèle gpt-realtime mis à jour présente des améliorations dans le suivi d’instructions complexes, l’appel d’outils avec précision et la production d’un discours « plus naturel et expressif ». Selon l’analyste, ces améliorations pourraient aider les entreprises à utiliser l’API pour permettre des interactions vocales naturelles à faible latence dans une multiplicité de cas d’usage, comme la transcription médicale en temps réel, les assistants de réservation conversationnels, le service clientèle pour les banques, les assurances et les télécommunications, et l’habilitation des employés dans les principaux secteurs verticaux. « Les entreprises qui accèdent au modèle via l’API peuvent utiliser deux nouvelles voix, Cedar et Marin », a indiqué le fournisseur du modèle. Microsoft, le plus grand investisseur d’OpenAI, a également annoncé cette semaine deux modèles de synthèse vocale qui, selon le géant technologique, donneront accès à de nombreux cas d’usage en entreprise.