L’IA générative, avec des outils tels que ChatGPT, Copilot, Claude ou Mistral Chat, s’impose progressivement dans le monde de l’entreprise. Cependant, son utilisation reste souvent discrète. Selon une étude récente, près d’un tiers des collaborateurs qui y ont recours choisissent de ne pas en informer leur hiérarchie.

L’adoption de l’IA générative a connu une forte hausse au cours des 12 derniers mois. 42 % des employés de bureau affirment utiliser des outils web ou SaaS tels que Copilot, ChatGPT ou Claude au travail, soit une augmentation de 16 points par rapport à 2024. Cette progression est moins marquée chez les professionnels IT, qui étaient déjà bien équipés l’an passé. Cependant, parler d’IA dans le cadre professionnel n’est pas toujours évident. D’après une étude récente du fournisseur Ivanti, 32 % des salariés utilisant des outils d’IA générative préfèrent garder leur utilisation secrète, sans en informer leur employeur.

Les motivations cachées de l’utilisation de l’IA

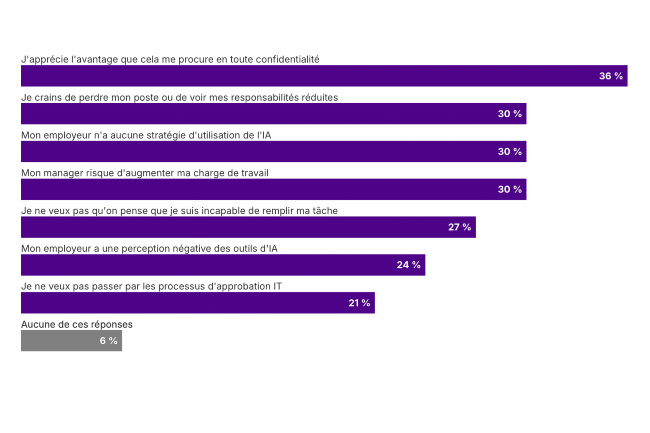

Pour 36 % des utilisateurs, il s’agit d’un avantage qu’ils estiment personnel. Travailler plus vite, mieux ou avec moins d’effort devient un atout qu’ils considèrent contre-productif à divulguer. Ces gains de productivité sont perçus comme un avantage compétitif qu’ils préfèrent garder pour eux. Cependant, cette discrétion n’est pas toujours une stratégie calculée. Pour 30 % des utilisateurs, elle est motivée par la peur de perdre leur emploi ou de voir leurs responsabilités réduites. L’angoisse de ne pas être perçu comme un contributeur irremplaçable incite certains salariés à éviter de révéler leur recours à l’IA. En outre, 27 % évoquent le syndrome de l’imposteur : la crainte que l’on pense qu’ils ne sont pas capables de réaliser certaines tâches seuls. L’IA serait donc perçue comme une aide dont il ne faut pas parler, de peur de passer pour incompétent.

Un autre facteur important est la crainte d’être pénalisé pour sa productivité accrue. En effet, plus de la moitié des répondants (52 %) estiment qu’en devenant plus performants grâce à l’IA, leurs employeurs leur confieront davantage de travail.

Une stratégie d’intégration plus structurée

L’utilisation d’outils d’IA non approuvés par l’entreprise présente également un risque en matière de cybersécurité. Les employés qui choisissent de recourir à des outils externes non validés par la DSI mettent en danger la confidentialité des informations et la sécurité des systèmes de l’entreprise. Cela expose les entreprises à des attaques potentielles, à des fuites de données sensibles et à une vulnérabilité accrue face aux cybermenaces. Ce phénomène de shadow AI, où les employés utilisent des outils sans en informer leur hiérarchie, nécessite une attention particulière afin de minimiser ces risques.

Face à ce phénomène, les entreprises doivent revoir leur approche en matière d’IA. Il est crucial d’établir un cadre clair et sécurisé pour intégrer l’IA de manière cohérente. Si certaines – comme La Poste – ont choisi de tout bloquer pour éviter le recours à des bots GenAI externes, il est recommandé d’établir un plan stratégique définissant comment l’IA soutiendra les objectifs de chaque département, tout en contribuant à la vision globale de l’entreprise. Ce plan doit identifier des cas d’usage prioritaires pour éviter une adoption inefficace. Il est également essentiel de documenter l’impact de l’IA pour prévenir les complexités et la dette technologique. Enfin, bien que 44 % des entreprises aient investi dans l’IA, de nombreux salariés manquent des compétences nécessaires pour en tirer pleinement parti. Il est crucial d’investir dans leur formation à long terme pour garantir une adoption réussie. Enfin, bien que de nombreuses entreprises aient déjà une charte informatique, celle-ci doit être mise à jour pour encadrer spécifiquement l’utilisation des outils d’IA, en définissant des lignes directrices claires et en garantissant le respect des normes de sécurité.