L’introduction d’un réentraînement spécifique dans toutes les couches d’apprentissage de l’IA pourrait transformer son développement en entreprise, faire gagner du temps, et réduire les coûts.

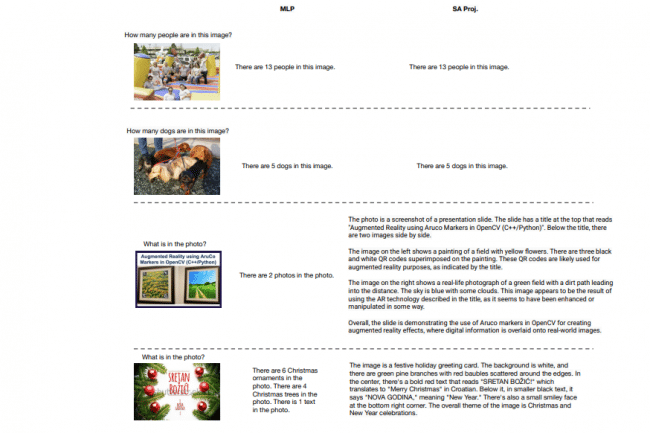

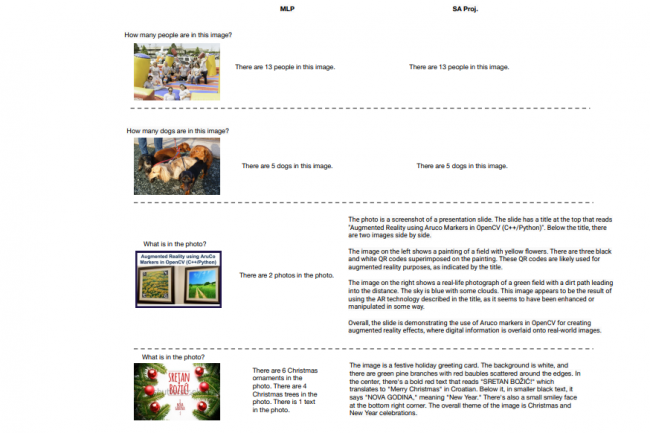

Une dernière étude de l’université de l’Illinois à Urbana-Champaign suggère que la perte de compétences souvent observée lors du réglage fin de grands modèles d’IA n’est peut-être pas un véritable oubli, mais un biais temporaire dans leurs résultats. En ne réentraînant que certaines couches spécifiques (self-attention projection layers, SA Proj), comme les composants d’auto-attention et les composants MLP (multi layer perceptron) supérieurs, les chercheurs ont découvert que les modèles pouvaient acquérir des capacités supplémentaires tout en conservant les anciennes, ce qui réduisait les coûts de réentraînement et améliorait la stabilité. Les chercheurs ont testé leur approche sur des modèles multimodaux comme LLaVA et Qwen2.5-VL, en affinant uniquement certaines couches sélectionnées afin de mesurer les gains d’apprentissage, la stabilité et le degré de préservation des connaissances dans plusieurs tâches. Les résultats mettent en évidence une approche potentiellement plus efficace pour les entreprises et les développeurs qui cherchent à mettre à jour des grands modèles de langages multimodaux sans compromettre les performances existantes. Cette distinction pourrait s’avérer très importante pour les équipes d’IA des entreprises, qui doivent souvent tenir compte de la question de la formation sans dégradation.

Surmonter les défis du réentraînement de l’IA

L’entrainement d’un grand modèle de langage multimodal peut coûter des millions de dollars et prendre plusieurs semaines. À mesure que les modèles et les ensembles de données prennent de l’ampleur, il devient de plus en plus difficile de les ré-entraîner à partir de zéro. « Une option consiste simplement à affiner le modèle pour la nouvelle tâche », ont expliqué les chercheurs. « Cependant, au moins pour les modèles plus simples, on sait que cette optimisation entraîne une perte de performance, de sorte qu’un modèle auparavant compétent pour de nombreuses tâches perd une part de son expertise pour cette tâche. » Afin de vérifier si ce problème se pose pour les LLM multimodaux actuels, l’équipe a procédé à une évaluation contrôlée. Elle a entraîné les modèles sélectionnés sur cinq tâches cibles, notamment la classification fine des oiseaux, le comptage, la réponse à des questions visuelles médicales, la lecture OCR et celle de l’heure. Elle a ensuite mesuré la baisse de performance sur huit benchmarks standard qui ne faisaient pas partie de l’ensemble d’ajustements.

Selon l’article, ces expériences ont conduit à deux découvertes essentielles. Le réglage des seules couches de projection d’auto-attention (Self-Attention Projection layers, SA Proj), la partie du modèle qui l’aide à décider sur quels éléments d’entrée se concentrer, a permis aux modèles d’apprendre d’autres tâches avec peu ou pas d’oubli mesurable. De plus, ce qui semblait initialement être des connaissances oubliées refaisait souvent surface lorsque le modèle était ensuite entraîné sur une autre tâche spécialisée. « Nous émettons donc l’hypothèse que ce qui ressemble à un oubli ou à une interférence après un réglage fin sur une tâche cible étroite est en réalité un biais dans la distribution des résultats qui résulte du changement d’attribution des tâches », ont ajouté les chercheurs. « Grâce à une analyse approfondie lors du réglage de la tâche de comptage, nous confirmons cette hypothèse : le réglage du MLP augmente la précision de la cible, mais augmente également la probabilité de produire des tokens et une baisse fortement corrélée de la précision de la tâche retenue, tandis que le réglage de l’auto-attention permet d’atteindre l’apprentissage cible sans trop de biais vers les tokens et sans perdre la précision retenue. » Les résultats montrent que la perte apparente sur les tâches retenues après un réglage fin étroit est souvent temporaire : « les performances qui baissent à un certain stade peuvent se rétablir par la suite », ont noté les chercheurs dans l’article. « Nous attribuons ce comportement à un changement mesurable dans la distribution des jetons suivants plutôt qu’à la perte de concepts. Une simple sonde de biais de comptage rend cette dérive visible, et une analyse Layer-Wise Residual-to-Logit (ResLogit) montre que la plupart du changement est écrit par les blocs MLP tardifs, et non par l’auto-attention. »

Implications pour les entreprises et état de préparation

Selon les analystes du secteur, ces résultats pourraient influencer la manière dont les entreprises abordent la maintenance et l’optimisation des modèles d’IA. « Cette recherche propose une approche innovante qui pourrait redéfinir les pratiques des développeurs d’entreprise, permettant ainsi de gagner du temps et de réduire les coûts grâce à la mise en place d’un entrainement spécifique à chaque couche », a déclaré Faisal Kawoosa, fondateur et analyste en chef chez Techarc. « Elle répond également au problème très courant dit « de l’oubli catastrophique ». Le réglage des couches de projection d’auto-attention (SA Proj) obtient des résultats d’apprentissage sans aucune baisse de performance. » Cependant, M. Kawoosa estime que même si les résultats sont prometteurs, une validation supplémentaire sera essentielle. D’autres tests dans plusieurs scénarios et environnements seront nécessaires pour confirmer l’efficacité et la robustesse de cette approche dans les entreprises.

Sanchit Vir Gogia, analyste en chef et CEO de Greyhound Research, pense pour sa part que l’approche mentionnée par les chercheurs pourrait rendre la maintenance de l’IA moins perturbante pour les équipes technologiques. « Au lieu de projets de recyclage gigantesques qui engloutissent des mois de travail et beaucoup de capitaux, les mises à jour peuvent désormais se faire discrètement et fréquemment, un peu comme l’entretien d’une voiture plutôt que la reconstruction d’un moteur », a avancé M. Gogia. Cependant, l’adoption d’un recyclage partiel à grande échelle nécessitera des processus de développement et une gouvernance plus solides. « Le recyclage partiel ne fonctionne que lorsque le processus est à la hauteur des promesses », a ajouté M. Gogia. « Les entreprises auront besoin d’un framework approprié pour ce flux de travail, notamment pour le contrôle des versions, le monitoring et la reproductibilité, afin de le rendre durable à grande échelle. »