Salesforce présenté un environnement de simulation pour évaluer et former les agents IA. Par ailleurs, l’éditeur a dévoilé des outils de comparaison et d’unification des données. L’objectif est d’aider les entreprises à aller vers l’IA agentique.

Une récente étude de chercheurs du MIT a montré que 95% des projets d’IA générative échouaient. Un dur retour à la réalité pour les éditeurs qui ne cessent de promouvoir les mérites de cette technologie. Pour éviter cette désillusion sur les agents IA, Salesforce a mobilisé son laboratoire de recherche pour trouver des solutions qui viennent d’être dévoilées.

Un simulateur d’agents IA

En premier lieu, Salesforce AI Research a présenté un simulateur d’agents IA. Pour cela, il s’est appuyé sur CRMArena-Pro, un environnement de test de tâches de service en une seule étape (single-turn). Ce framework de simulateur est capable d’évaluer les performances des agents IA dans des scénarios complexes à étapes multiples et à agents multiples, notamment les prévisions de ventes, le triage des situations de service et les processus de configuration, de tarification et de devis (Configure, Price, Quote, CPQ).

CRMArena-Pro exploite également des données synthétiques, ce qui, selon Salesforce, donne la possibilité d’effectuer des appels API en toute sécurité tout en appliquant des mesures de protection strictes pour protéger les informations personnelles identifiables (Personally Identifiable Information, PII). Salesforce ajoute que cet environnement fonctionne comme un jumeau numérique d’une entreprise, capturant toute la complexité des opérations métiers et aidant les clients à tester les agents dans des situations telles que les escalades du service client ou les perturbations de la chaîne d’approvisionnement avant leur mise en service.

Un benchmark pour évaluer les agents

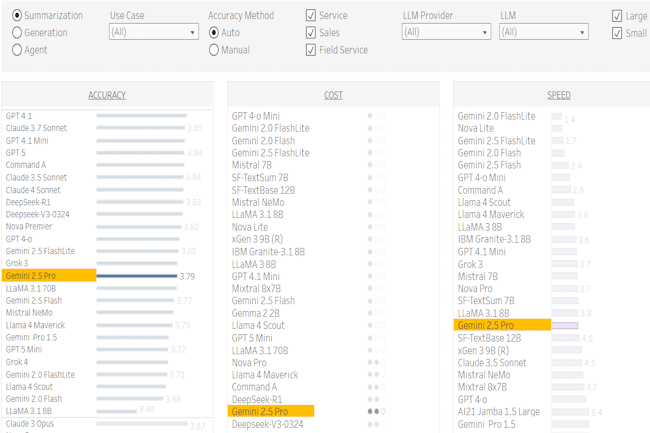

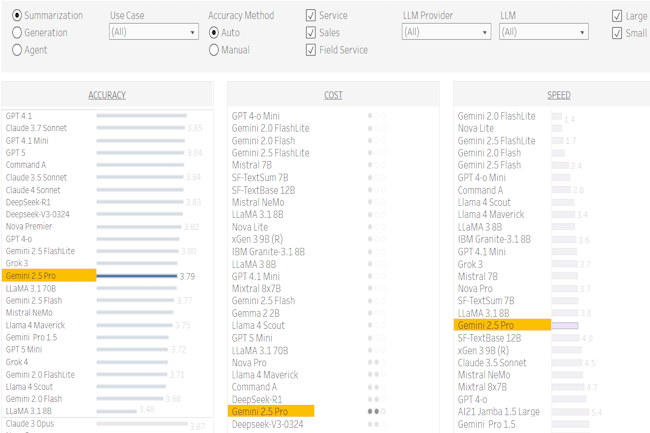

L’outil Agentic Benchmark for CRM a été conçu pour évaluer l’efficacité des agents d’IA dans des contextes métiers spécifiques : le service client, le service sur le terrain, le marketing et les ventes. Il mesure cinq indicateurs d’entreprise (précision, coût, rapidité, confiance et sécurité, et durabilité) afin de déterminer si les agents sont prêts à être déployés dans le monde réel. L’éditeur a indiqué avoir ajouté un indicateur de durabilité pour mettre en évidence l’impact environnemental relatif des systèmes d’IA. Il peut aider les entreprises à aligner la taille du modèle sur le niveau d’intelligence spécifique requis par un agent pour accomplir une tâche propre à l’entreprise, en minimisant les ressources IT utilisées par l’agent. De plus, le laboratoire a publié deux comparatifs complémentaires, MCP-Eval et MCP-Universe, pour évaluer les agents et suivre les LLM lorsqu’ils interagissent avec les serveurs MCP dans des cas d’usage réels. MCP-Eval utilise des tâches synthétiques pour une évaluation à l’échelle et automatique sur un large éventail de serveurs MCP, tandis que MCP-Universe exploite des tâches complexes et réelles avec des évaluateurs basés sur l’exécution pour soumettre les agents à des tests de résistance dans des scénarios complexes.

Unification des données

Enfin, concernant la fonctionnalité Account Matching de Data Cloud, elle est destinée à garantir que les agents IA aient accès à des données unifiées et de haute qualité. Salesforce AI Research s’est associé aux équipes produit de Salesforce pour affiner les LLM et les SLM afin d’alimenter Account Matching, qui peut identifier les enregistrements en double, les champs incomplets et les conventions de nommage incohérentes, puis les réconcilier entre les systèmes de données en un seul enregistrement faisant autorité. Salesforce a cité l’exemple d’un client qui a utilisé un outil propriétaire exploitant Account Matching et qui a pu unifier plus d’un million de comptes avec un taux de réussite de 95 % dès le premier mois, tout en réduisant le temps de traitement moyen de 30 minutes.