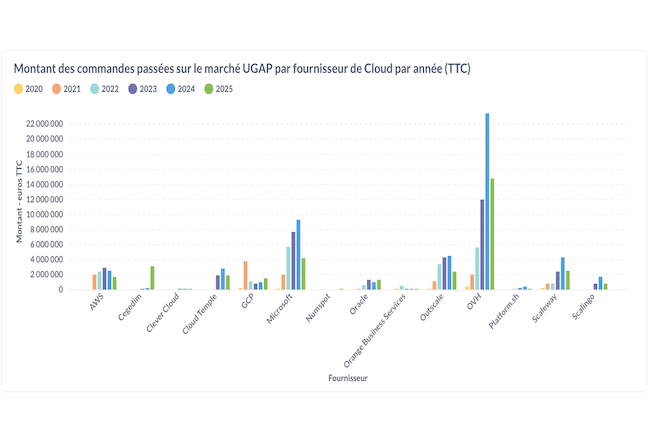

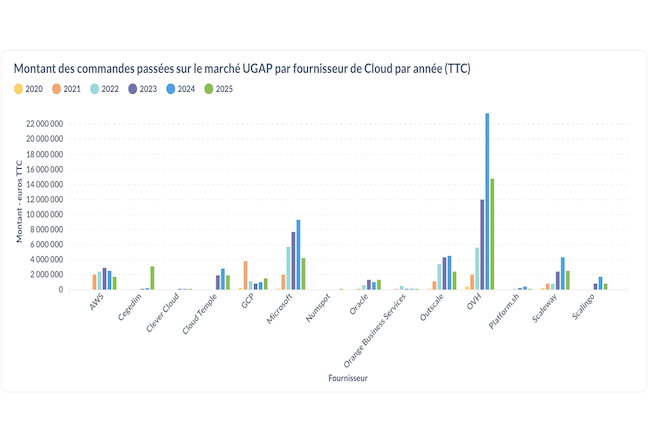

– OVH et Azure en tête des commandes cloud UGAP en 2024. Sur l’année écoulée, les administrations françaises ont passé d’importantes commandes cloud (IaaS) via l’union des groupements d’achats publics. OVHcloud arrive en tête avec 23,4 M€ de commandes publiques. Microsoft suit avec 9,3 M€. Les trois autres principaux bénéficiaires sont Outscale (4,4 M€), Scaleway (4,3 M€) et AWS (2,5 M€). Cette répartition illustre la diversité des fournisseurs retenus pour accompagner la transformation numérique du secteur public, tout en mettant en avant la place prépondérante des acteurs français dans les marchés publics du cloud. Reste à savoir si toutes les commandes publiques passent vraiment par l’Ugap car il existe aussi d’autres centrales d’achats comme Resah et Uniha pour le secteur de la santé.

– xAI lance Grok 4. La société d’Elon Musk a publié son dernier modèle d’IA et dévoilé dans le même temps un abonnement facturé 300 $HT par mois, SuperGrok Heavy. Ce dernier est facturé au prix fort par rapport à la concurrence comme Perplexity Max (200 $HT) et Google AI Ultra (275 $HT). « Grok 4 est meilleur que le niveau doctoral dans toutes les matières académiques, sans exception », a lancé le milliardaire. xAI affirme que son dernier LLM affiche des performances de haute volée, notamment sur le test Humanity Last Exam. Selon xAI, Grok 4 a obtenu par défaut un score de 25,4 % surpassant Gemini 2.5 Pro de Google, qui a obtenu 21,6 %, et o3 (high) d’OpenAI, qui a obtenu 21 %. Reste à savoir si toute cette performance aidera le chatbot maison éponyme à débiter moins de propos racistes et antisémites.

– AWS dégaine ses instances GB200. Plusieurs mois après Coreweave, c’est au tour d’Amazon Web Services de pousser dans son cloud des instances EC2 GB200 NVL72 (Grace Blackwell) de Nvidia. Rappelons que le cluster GB200 NVL72 est un système massif et performant comprenant 36 processeurs Grace (Arm) et 72 GPU Blackwell reliés entre eux via NVLink-C2C (900 Go/s) et est utilisé pour la programmation et l’entrainement avancé de LLM. « Les instances P6e-GB200 UltraServers et P6-B200 permettent d’accélérer l’entraînement des modèles d’IA de nouvelle génération et d’améliorer les performances de l’inférence en temps réel dans la production », explique AWS. « Vous pouvez utiliser les UltraServers P6e-GB200 et les instances P6-B200 pour former des modèles de fondation de pointe tels que le mélange d’experts et les modèles de raisonnement, et les déployer dans des applications d’IA générative et agentique telles que la génération de contenu, les copilotes d’entreprise et les agents de recherche approfondie. »