L’éditeur Securiti a présenté Gencore AI, un outil qui s’appuie sur les capacités existantes de sécurité et de conformité des données pour l’adapter à la protection et à la gouvernance de l’IA générative.

La sécurité des systèmes d’IA génératives, des copilotes ou des agents IA monte en puissance. Pour répondre à cette problématique, Securiti vient de lancer Gencore AI, un outil pour contrôler et sécuriser les données de l’entreprise servant aux solutions créant des modèles d’IA. « La connexion sécurisée aux systèmes de données, avec la garantie que les contrôles et la gouvernance sont respectés tout au long du pipeline d’IA, est le principal obstacle au déploiement à grande échelle de systèmes d’IA générative dans les entreprises », a déclaré Rehan Jalil, le CEO de Securiti.

« Constatant que la majorité des données d’entreprise sont des données non structurées, il est essentiel de gouverner et de contrôler ces actifs quand ces données sont exploitées pour alimenter l’IA », a-t-il expliqué. « Par ailleurs, comme les technologies de Gencore AI sont propriétaires, les entreprises peuvent se connecter en toute sécurité à des centaines de systèmes de données tout en préservant les contrôles et la gouvernance des données », a-t-il ajouté.

Des graphes de connaissances maison

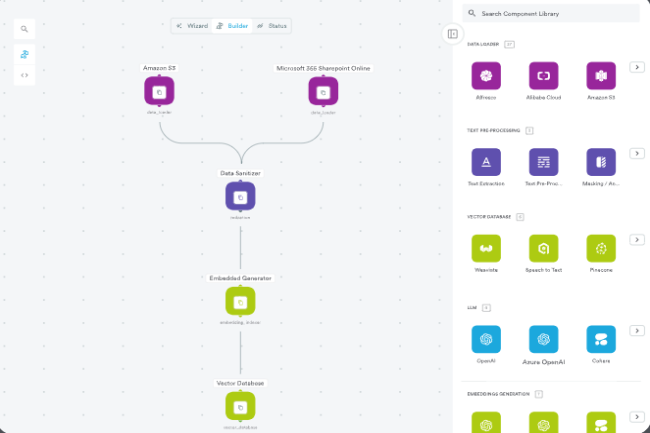

En s’appuyant sur les contrôles de sécurité existants, Gencore AI de Securiti construit des systèmes d’IA alignés sur les politiques et les exigences règlementaires de l’entreprise pour protéger les données sensibles contre les attaques malveillantes. « Avec Gencore AI, les entreprises peuvent construire facilement et rapidement des systèmes d’IA sécurisés de niveau entreprise », a fait valoir Rehan Jalil. « L’outil est alimenté par un graphe de connaissances unique qui maintient des informations granulaires et contextuelles sur les données et les systèmes d’IA ». Le graphe de connaissances unique auquel fait référence le dirigeant s’appelle « Data Command Graph », ou graphe de commande des données.

« La fonction tire parti de la capacité de Securiti à découvrir « les données sensibles et les systèmes d’IA à travers une série de cloud publics, des cloud de données, de cloud privés et d’applications SaaS, sur la base de centaines de classificateurs intégrés et de plus de 400 connecteurs natifs. », a-t-il détaillé. Apparemment, ce graphe fournira des informations granulaires jusqu’au niveau du fichier, de la colonne, de la ligne ou du CLOB (Character Large Objects), en prenant en charge des « milliards de nœuds ». Cette fonctionnalité peut faciliter le traitement d’énormes quantités de données non structurées, en plus des données structurées, sur lesquelles les entreprises forment généralement leurs modèles intelligents.

Un pare-feu LLM avec des capacités contextuelles

À mesure que les entreprises déploient des solutions GenAI à grande échelle, les pare-feux LLM deviennent extrêmement pertinents en tant qu’outil de sécurisation des interactions de l’IA, comme la détection et le blocage des accès non autorisés aux données et des comportements anormaux. Il existe plusieurs fournisseurs de pare-feu LLM, notamment Open AI, Nvidia, Anthropic et Scale AI. Selon Securiti, par rapport aux offres existantes, le pare-feu LLM de Gencore AI comprend des fonctionnalités supplémentaires, notamment des contrôles alignés sur les recommandations de l’OWASP (Open Worldwide Application Security Project), des politiques de sécurité préconfigurées pour l’IA et la prise en compte du contexte des données.

« Gencore AI protège automatiquement les informations sensibles et maintient la gouvernance des données de l’entreprise », a affirmé Rehan Jalil. « Grâce à ses connaissances réglementaires intégrées, Gencore AI garantit aussi la conformité des processus d’IA avec les réglementations pertinentes, comme l’IA Act européen et le cadre de gestion des risques liés à l’IA (AI RMF) du NIST américain. » GenCore AI de Securiti est déjà disponible sous forme d’abonnements divers, basés sur les fonctions.