La plateforme Hugging Face a présenté Hugs, des microservices d’inférence pour faciliter le déploiement des applications d’IA génératives basées sur des modèles ouverts. Ils sont en concurrence avec les NIM de Nvidia en misant sur des tarifs plus abordables et une orientation assumée vers les modèles ouverts.

Lancée récemment par le fournisseur de modèles et de référentiels d’IA générative, Hugging Face Generative AI Services, ou Hugs, est actuellement la seule alternative possible au NIM (Nvidia Inference Microservices) de Nvidia. Rappelons que ce dernier a été présenté en mars dernier puis déployé en juin avec la suite AI Enterprise de Nvidia. Unique en son genre, il facilite le déploiement de modèles d’IA générative dans n’importe quel cloud ou datacenter en intégrant des moteurs d’inférence optimisés, des API et la prise en charge de modèles d’IA personnalisés ou génériques dans des conteneurs sous forme de microservices. Si NIM a suscité l’intérêt des développeurs, c’est qu’il est moins fastidieux à configurer et à exécuter que des frameworks et des packages comme vLLM, TensorRT LLM et LMDeploy, aussi utilisés pour le déploiement de modèles de base pour l’inférence.

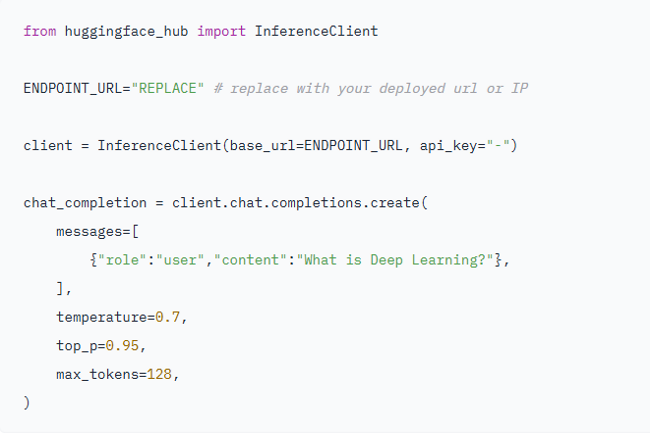

Les HUGS sont également des microservices d’inférence optimisés qui facilitent et accélèrent le développement d’applications d’IA. Selon Hugging Face, les Hugs sont construits à l’aide de bibliothèques et de frameworks open source comme Text Generation Inference (TGI) et Transformers et peuvent exécuter des modèles sur des accélérateurs GPU de Nvidia ou AMD. « La prise en charge d’AWS Inferentia et des Google TPU (tensor processing units) sera bientôt ajoutée », a déclaré l’entreprise. Par contre, son billet de blog sur l’offre ne mentionne pas la prise en charge du matériel Intel.

Prix et disponibilité de Hugs

L’une des principales différences entre NIM et Hugs est la tarification, qui laisse penser que les entreprises peuvent réaliser des économies en choisissant l’outil alternatif à celui de Nvidia. Sur Google Cloud et AWS, Hugs est facturé 1 dollar par heure et par conteneur, contre 1 dollar par heure et par GPU pour NIM, auquel il faut ajouter les frais de licence de la suite Nvidia AI Enterprise.

Outre AWS et Google Cloud, où HUGS peut être déployé via les marketplace d’AWS et de GCP, Hugging Face offre un accès via sa plateforme Enterprise Hub, laquelle permet de travailler avec des modèles et de créer des applications basées sur l’IA, accessible par abonnement au tarif de 20 dollars HT/utilisateur/mois. Séparément, pour AWS, l’entreprise offre une période d’essai gratuite de 5 jours pour que les développeurs puissent tester Hugs gratuitement. « HUGS est aussi disponible gratuitement via DigitalOcean, mais des frais de calcul s’appliquent », a indiqué l’entreprise.

Uniquement pour les modèles ouverts

Pour l’instant, Hugs semble limité aux modèles ouverts ce qui n’est pas le cas de NIM. HUGS prend en charge 13 modèles, à savoir : Llama-3.1-8B-Instruct, Llama-3.1-70B-Instruct, Llama-3.1-405B-Instruct-FP8, Hermes-3-Llama-3.1-8B, Hermes-3-Llama-3.1-70B, Hermes-3-Llama-3. 1-405B-FP8, Nous-Hermes-2-Mixtral-8x7B-DPO, Mixtral-8x7B-Instruct-v0.1, Mistral-7B-Instruct-v0.3, Mixtral-8x22B-Instruct-v0.1, Gemma-2-27b-it, Gemma-2-9b-it, et Qwen2.5-7B-Instruct d’Alibaba. La page de documentation de Hugs précise que Hugging Face devrait bientôt prendre en charge des modèles comme Deepseek, T5, Phi et Command R. D’autres modèles multimodaux et d’intégration devraient être ajoutés prochainement, notamment Idefics, Llava, BGE, GTE, Micbread, Arctic, Jina et Nomic.

Nvidia affirme que NIM prend en charge davantage de modèles, y compris ses modèles propriétaires Nemotron, les modèles de Cohere, A121, Adept, Getty Images, Shutterstock, et les modèles ouverts de Google, Hugging Face, Meta, Microsoft, Mistral AI, Stability AI. Cependant, la documentation NIM de Nvidia montre que NIM est actuellement disponible pour des modèles comme Code Llama 13B Instruct, Code Llama 34B Instruct, Code Llama 70B Instruct, Llama 2 7B Chat, Llama 2 13B Chat, Llama 2 70B Chat, Llama 3 Swallow 70B Instruct V0.1, Llama 3 Taiwan 70B Instruct, Llama 3.1 8B Base, Llama-3.1-8b-instruct, Llama 3. 1 70B Instruct, Llama 3.1 405B Instruct, Meta Llama 3 8B Instruct, Meta Llama 3 70B Instruct, Mistral 7B Instruct v0. 3, Mistral NeMo 12B Instruct, Mistral NeMo Minitron 8B 8K Instruct, Mixtral 8x7B Instruct v0.1, Mixtral 8x22B Instruct v0.1, Nemotron 4 340B Instruct, Nemotron 4 340B Reward, et Phi 3 Mini 4K Instruct.