Les distributions de Llama Stack de Meta regroupent plusieurs briques et API pour faciliter le développement de bout en bout d’applications d’IA générative.

Pour simplifier la vie des développeurs travaillant avec des LLM pour concevoir des applications d’IA générative, Meta partage ses premières distributions officielles Llama Stack. Dévoilées le 25 septembre, ces dernières regroupent plusieurs fournisseurs d’API Llama Stack qui fonctionnent bien ensemble pour fournir un point d’accès unique aux développeurs, a annoncé Meta dans un billet de blog présentant la dernière famille de LLM Llama 3.2. Celle-ci comprend des LLM de computer vision de petite et moyenne taille (11B et 90B) et des modèles légers en texte seul (1B et 3B) qui s’intègrent aussi bien à des terminaux en bordure de réseau (edge) que mobiles.

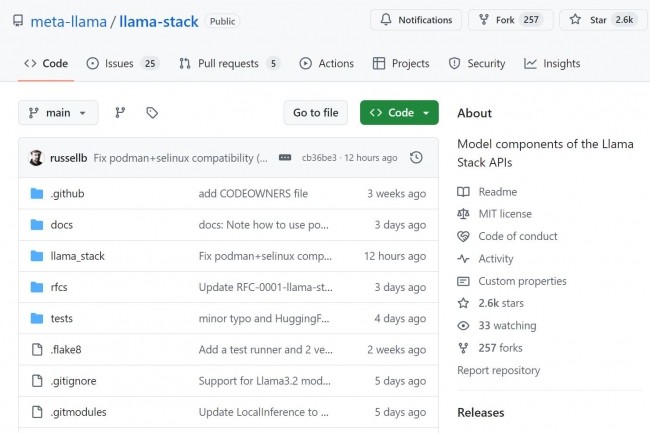

La pile Llama définit des éléments de base pour la mise sur le marché d’applications d’IA générative. Ces modules couvrent le cycle de vie du développement, de l’entraînement et du réglage fin du modèle à l’évaluation du produit, jusqu’à la construction et à l’exécution d’agents d’IA et d’applications basés sur de la génération augmentée par récupération (RAG) en production. Les spécifications de l’API Llama Stack ainsi que les fournisseurs d’API et les distributions sont disponibles sur GitHub.

Des distributions Llama Stack multi-environnements

Parmi les fournisseurs Llama Stack, on trouve AWS Bedrock, Chroma ou encore Ollama et TGI. La maison-mère de Facebook en fait également partie avec Meta Reference. Le fournisseur cherche à s’assurer que les développeurs peuvent assembler des solutions d’intelligence artificielle en utilisant des éléments cohérents et interdépendants sur toutes les plateformes. Les distributions de Llama Stack doivent aider les développeurs à travailler avec les modèles Llama dans des environnements multiples, y compris sur site, un cloud ou un terminal mobile a déclaré Meta. La pile Llama se compose d’un ensemble d’API : inférence, sécurité, mémoire, système d’agents, évaluation post-entraînement, génération de données synthétiques et notation des récompenses.